Docker, créer et administrer

vos conteneurs d'applications

Allez-y doucement avec le WiFi!

N'utilisez pas votre hotspot.

Ne chargez pas de vidéos, ne téléchargez pas de gros fichiers pendant la formation.

Présentations

Bonjour, je suis:

- 👨🏾🎓 djalal

Cet atelier se déroulera de 9h à 17h.

La pause déjeuner se fera entre 12h et 13h30.

(avec 2 pauses café à 10h30 et 15h!)

N'hésitez pas à m'interrompre pour vos questions, à n'importe quel moment.

Surtout quand vous verrez des photos de conteneurs en plein écran!

Une brève introduction

Ce cours a été écrit à l'origine comme support à des ateliers en présentiel

Ce contenu est maintenu par Jérôme Petazzoni et de nombreux contributeurs

La traduction intégrale depuis l'anglais est réalisée et maintenue par @djalal

Vous pouvez aussi le parcourir à votre propre rythme.

Nous avons inclus autant d'information que possible dans les diapositives.

Nous vous recommandons d'avoir un instructeur pour vous aider...

... sauf si vous êtes à l'aise avec la lecture minutieuse de la documentation Docker...

... et avec la recherche de réponses dans les forums Docker, StackOverflow, et autres boutiques.

À propos de ces diapositives

Tout le contenu est disponible dans un dépôt public Github:

Vous pouvez obtenir une version à jour de ces diapos ici:

https://container.training/ (anglais) ou https://docker.djal.al/ (français)

À propos de ces diapositives

Tout le contenu est disponible dans un dépôt public Github:

Vous pouvez obtenir une version à jour de ces diapos ici:

https://container.training/ (anglais) ou https://docker.djal.al/ (français)

- Coquilles? Erreurs? Questions? N'hésitez pas à passer la souris en bas de diapo...

👇 Essayez! Le code source sera affiché et vous pourrez l'ouvrir dans Github pour le consulter et le corriger.

Détails supplémentaires

Cette diapo a une petite loupe dans le coin en haut à gauche.

Cette loupe signifie que ces diapos apportent des détails supplémentaires.

Vous pouvez les zapper si:

vous êtes pressé(e);

vous êtes tout nouveau et vous craignez la surcharge cognitive;

vous ne souhaitez que l'essentiel des informations.

Vous pourrez toujours y revenir une autre fois, ils vous attendront ici ☺

Chapitre 1

(auto-generated TOC)

Chapitre 2

(auto-generated TOC)

Chapitre 3

(auto-generated TOC)

Chapitre 4

(auto-generated TOC)

Chapitre 5

(auto-generated TOC)

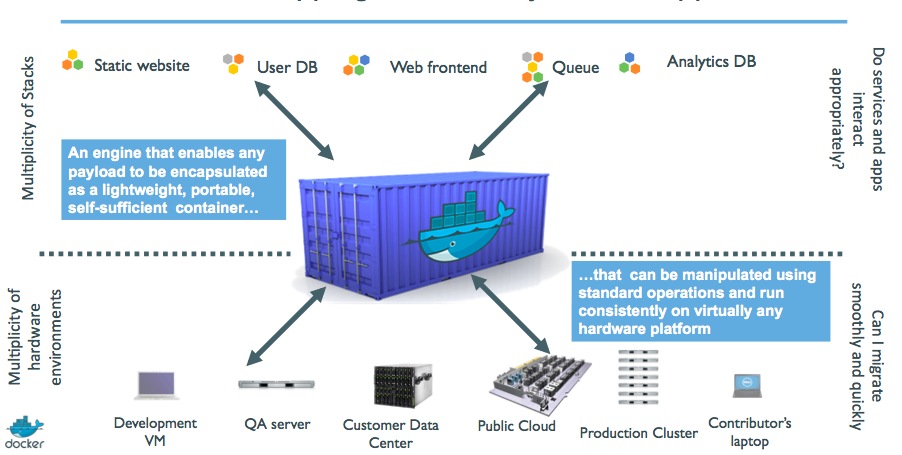

Docker vu d'hélicoptère

(automatically generated title slide)

Docker vu d'hélicoptère

Dans cette leçon, nous apprendrons:

Pourquoi les conteneurs (pitch d'ascenseur non-technique)

Pourquoi les conteneurs (version technique du pitch d'ascenseur)

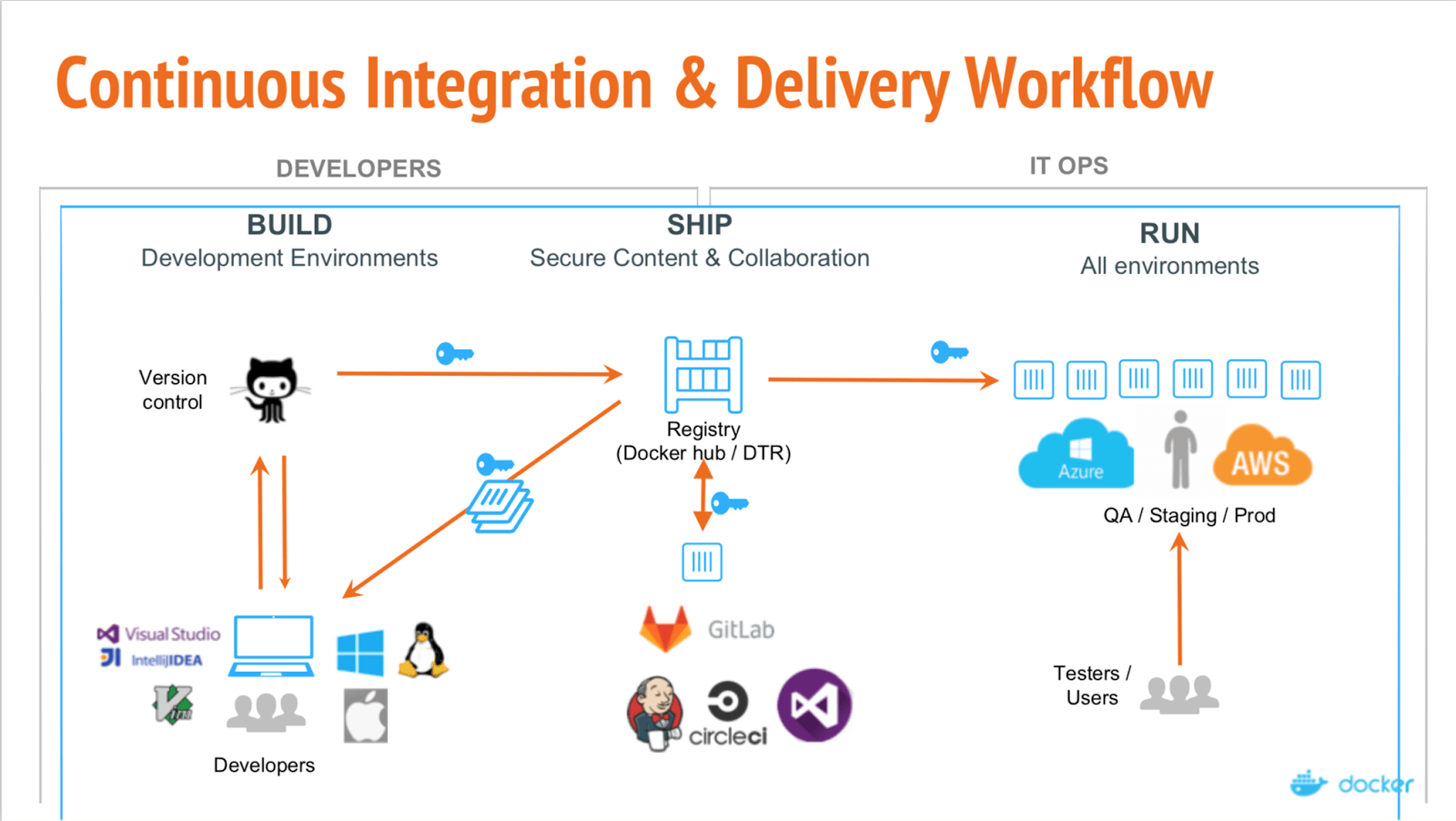

Comment Docker nous aide à les construire, transporter et lancer

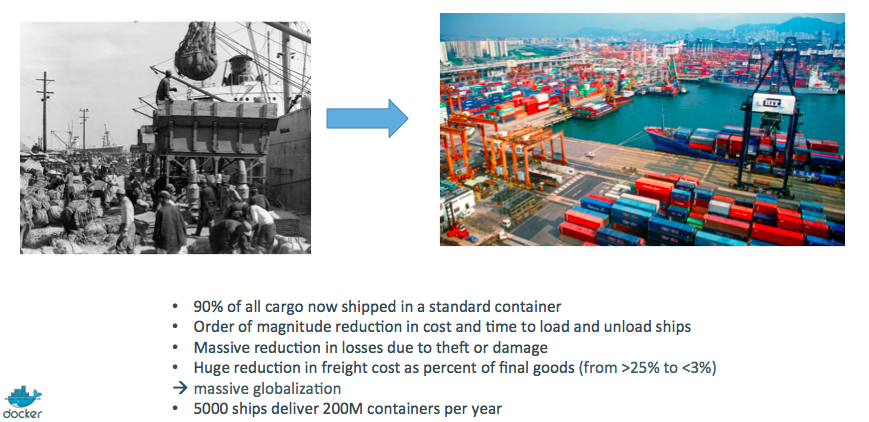

L'Histoire des conteneurs

On ne va pas (encore!) lancer Docker ou des conteneurs dans ce chapitre.

Pas de souci, nous y arriverons assez tôt!

OK... Pourquoi ce buzz autour des conteneurs?

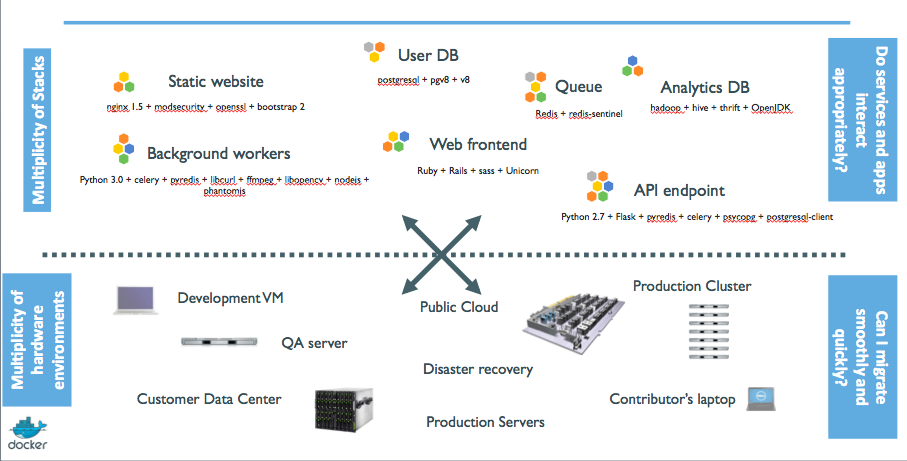

L'industrie logicielle a changé

Avant:

- applications monolithiques

- longs cycles de développements

- environnement unique

- montée en charge lente

Maintenant:

- services découplés

- améliorations rapides, itératives

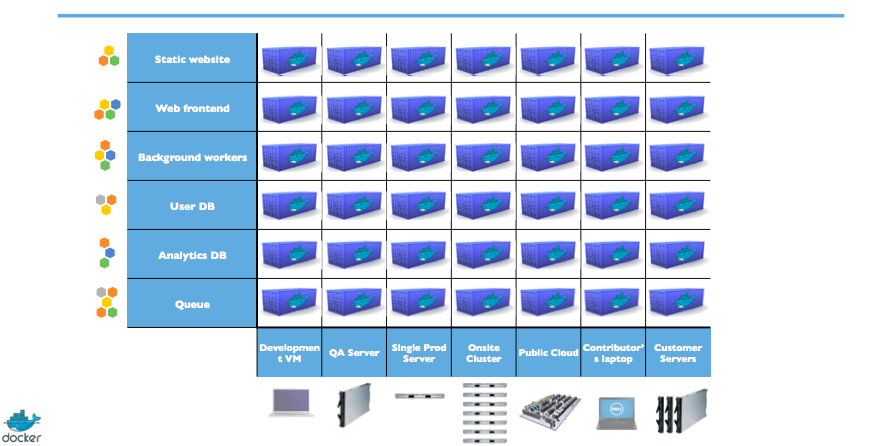

- environnements multiples

- montée en charge rapide

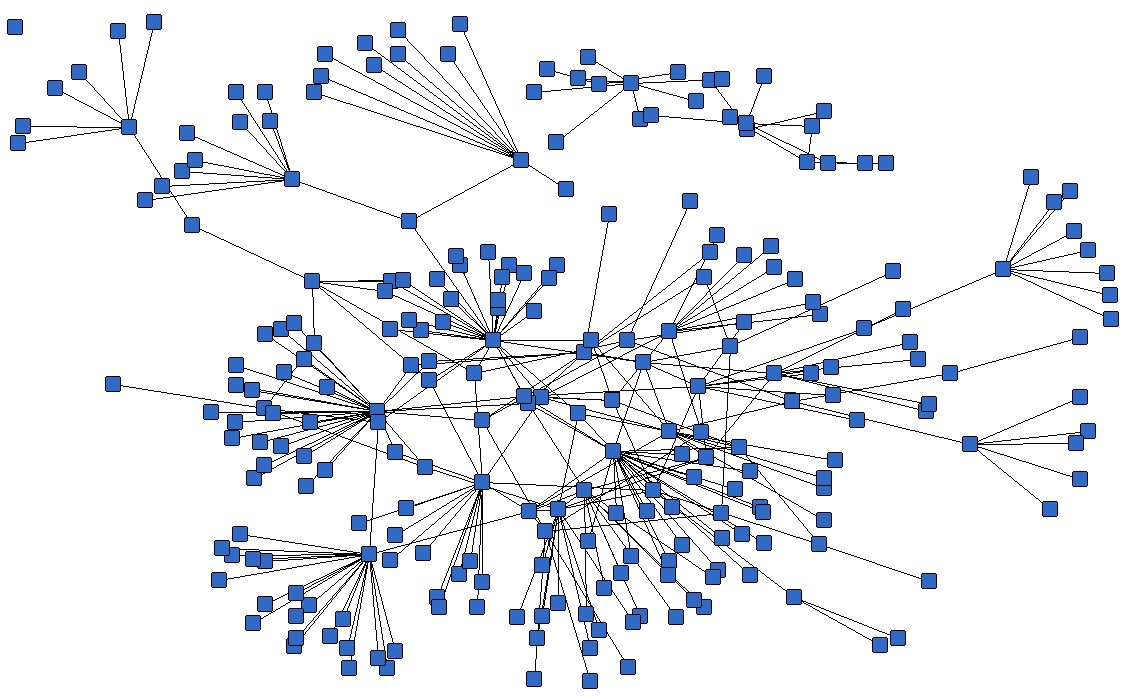

Déployer devient très compliqué

Nombreuses technos différentes:

- langages

- frameworks

- bases de données

Nombreux environnements différents:

- espaces de développement individuels

- pre-production, QA, staging...

- production: on-prem, cloud, hybride

Pitch d'ascenseur

(pour vos collègues développeurs et admin. système)

Echapper à l'enfer des dépendances

Ecrire les instructions d'installation dans un fichier

INSTALL.txtAvec ce fichier, écrire un script

install.shqui va marcher pour vousTraduire ce fichier en

Dockerfile, le tester sur votre machineSi le Dockerfile passe sur votre machine, il passera n'importe où

Réjouissez-vous, car vous êtes sauvé de l'enfer des dépendances et du "ça marche sur ma machine"

Plus jamais de "ça marchait en dev - c'est le problème des admins maintenant!"

Intégrez des développeurs et contributeurs rapidement

Ecrire les Dockerfiles pour les composants applicatifs

Utiliser des images pré-générées du Docker Hub (mysql, redis, etc.)

Décrire votre suite logicielle avec un fichier Compose

Intégrer quelqu'un avec deux commandes:

git clone ...docker-compose upAvec ça, vous pouvez monter des environnements de développement, intégration ou QA en quelques minutes!

Implémenter facilement une CI stable

Montez un environnement de test avec un Dockerfile ou un fichier Compose

Pour chaque lancement de test, montez un nouveau conteneur (ou une suite complète)

Chaque test est lancé dans un environnement propre.

Aucune pollution des précédents tests

Bien plus rapide et économique que de monter des VMs à chaque fois!

Utiliser des images de conteneurs comme artefacts de build

Générez votre appli à partir de Dockerfiles

Stockez les images résultantes dans un dépôt

Stockez-les pour toujours (ou aussi longtemps que nécessaire)

Testez ces images en QA, CI ou intégration...

Lancez les mêmes images en production

Quelque chose est cassé? Repassez à l'image précédente.

Diagnostic d'une ancienne régression? Une ancienne image est toujours là pour vous!

Les images contiennent toutes les bibliothèques, dépendances, etc. nécessaires au lancement de l'appli.

Découplez la "plomberie" de la logique applicative

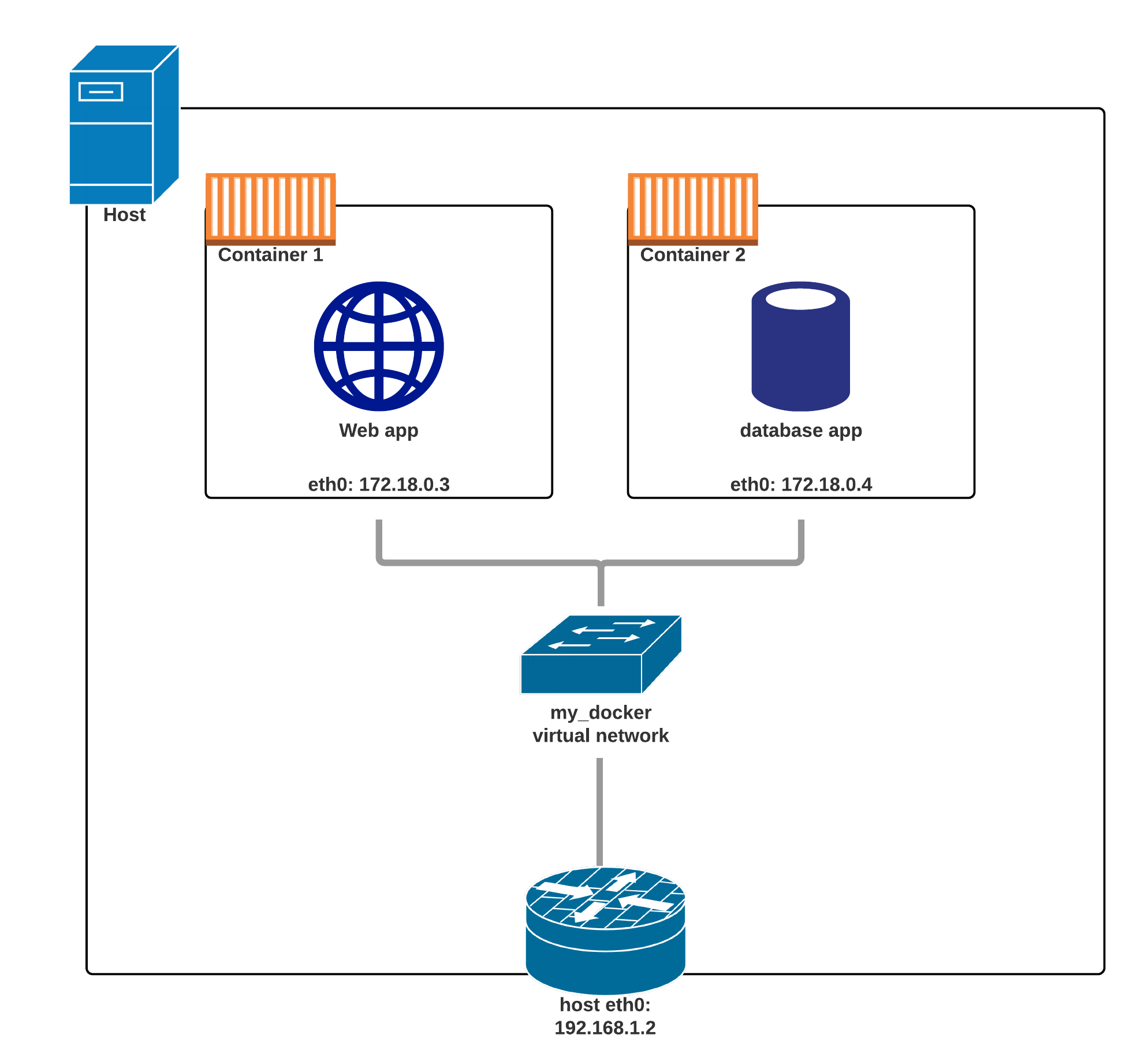

Ecrivez votre code pour qu'il se connecte à des services nommés ("db", "api", etc.)

Utilisez Compose pour démarrer votre suite

Docker va fournir un DNS pour conteneur pour résoudre ces noms de services

Vous pouvez maintenant monter en charge, ajouter des répartiteurs de charge, de la réplication... sans changer votre code.

Note: ce n'est pas couvert dans cet atelier d'introduction!

Formats et APIs, avant Docker

Aucun format d'échange standard.

(Non, un fichier tarball n'est pas un format!)Difficile d'utiliser des conteneurs pour les développeurs.

(Quel est l'équivalent d'undocker run debian?)En conséquence, ils restent cachés des utilisateurs finaux.

Aucun composant réutilisable, APIs ou outils.

(Au mieux, abstractions de VMs, e.g libvirt)

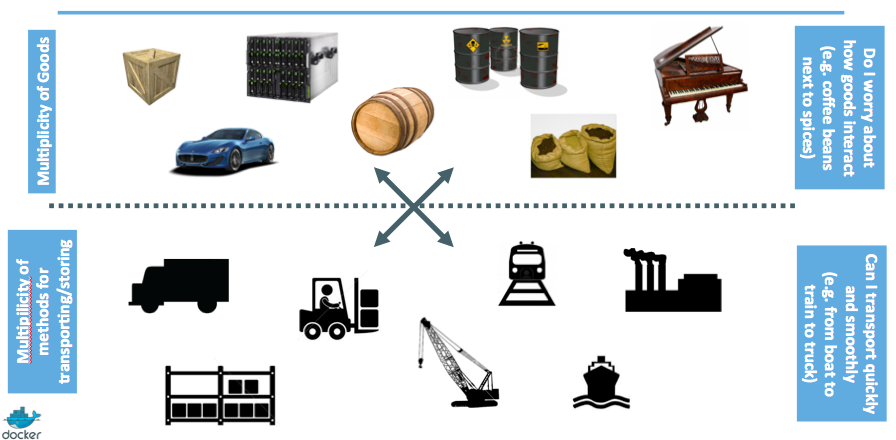

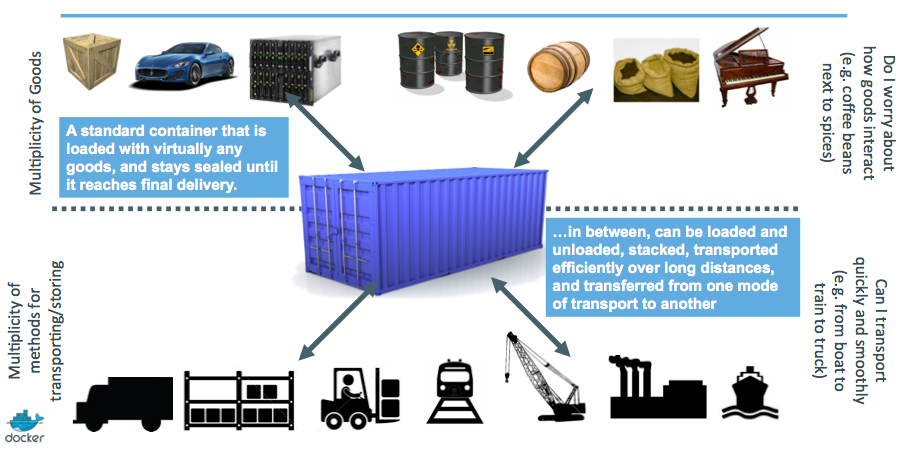

Analogie:

- Transporter des conteneurs n'est pas une question de boîte d'acier.

- Ce sont des boîtes d'acier de taille standard, avec les mêmes crochets et trous.

Formats et APIs, après Docker

Standardiser le format de conteneur, parce que les conteneurs n'étaient pas portables.

Rendre les conteneurs faciles à utiliser pour les développeurs.

Focus sur les composants réutilisables, APIs et l'écosystème d'outils standard.

Amélioration par rapport aux outils ad-hoc, interne et spécifique.

Livraison, avant Docker

Déploiement par paquets: deb, rpm, gem, jar, homebrew...

Enfer des dépendances

"Ça marche chez moi."

Base de livraison souvent réalisée de zéro (debootstrap...) et fragile.

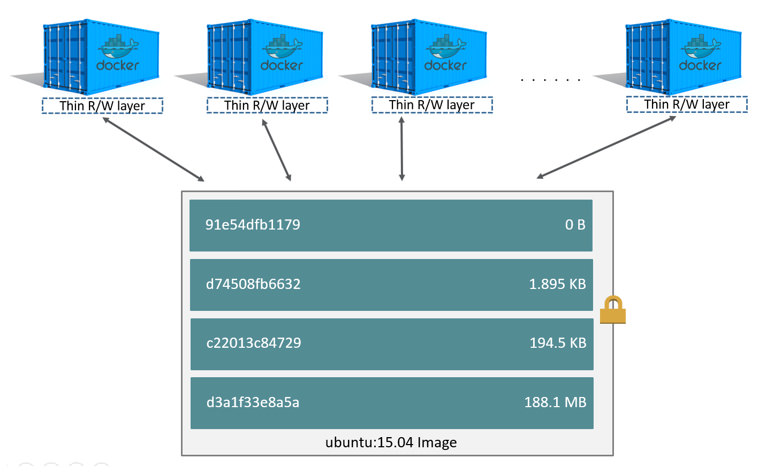

Livraison, après Docker

Livrez des images de conteneurs avec toutes leurs dépendances.

De plus grosses images, mais sous-découpées en couches.

Ne livre que les couches qui ont changé.

Économise du disque, du réseau et de la mémoire.

Exemple

Couches (Layers):

- CentOS

- JRE

- Tomcat

- Dépendances

- Application JAR

- Configuration

Devs vs Ops, avant Docker

On va livrer un fichier tarball (ou un hash de commit) avec ses instructions.

Avec un environnement de dev très différent de la production.

Sauf que les admin. système n'ont pas toujours un environnement de test eux-mêmes...

... et quand ils l'ont, il peut différer de celui des devs.

Donc les admin. système doivent déterminer les différences, et faire en sorte que ça marche...

... ou le renvoyer aux développeurs.

Déployer du code est cause de friction et de délais.

Devs vs Ops, après Docker

On va livrer une image de conteneur ou un fichier Compose.

Un admin. système pourra toujours lancer cette image de conteneur.

Un admin. système pourra toujours lancer ce fichier Compose.

Les admin. doivent toujours adapter la configuration à l'environnement de prod, mais ils ont au moins un point de référence.

L'outillage des admin. système permet d'utiliser la même image en dev et prod.

Les développeurs pourront plus facilement être mis en position de lancer les déploiements eux-mêmes.

Histoire des conteneurs ... et de Docker

(automatically generated title slide)

Premières expérimentations

Cela fait très longtemps que les conteneurs existent.

(Voir cet excellent billet par Serge Hallyn pour plus de détails historiques.)

Conteneurs = moins cher que les VMs

Utilisateurs: fournisseurs d'hébergement.

Audience hautement spécialisée avec une forte culture d'admin. système.

Conteneurs = plus facile que les VMs

Je ne peux pas parler pour Heroku, mais les conteneurs étaient l'arme secrète de dotCloud (parmi d'autres).

dotCloud maintenait un PaaS, via un moteur de conteneur personnalisé.

Ce moteur était basé sur OpenVZ (et plus tard, LXC) et AUFS.

Tout a commencé (vers 2008) par un simple script Python.

En 2012, le moteur comptait plusieurs composants Python (env. 10)

(et env. 100 micro-services!)Fin 2012, dotCloud reconstruit le moteur de conteneur.

Le nom de code de ce projet est "Docker".

Première version publique de Docker

Mars 2013, Pycon, Santa Clara:

"Docker" est montré en public pour la première fois.Il est publié avec une licence open source.

Réactions et retours très positifs!

L'équipe dotCloud est progressivement réaffectée au développement de Docker.

La même année, dotCloud change de nom pour s'appeler Docker.

En 2014, l'activité PaaS est revendue.

Premiers utilisateurs de Docker

Gestionnaires de PAAS (Flynn, Dokku, Tsuru, Deis...)

Utilisateurs de PAAS (ceux assez gros pour justifier la construction de leur propre PAAS)

Services d'intégration continue

développeurs, développeurs, développeurs

Boucle de retours positifs

En 2013, la technologie sous-tenant les conteneurs (cgroups, namespaces, stockage copy-on-write, etc.)

La popularité croissante de Docker et des conteneurs a mis en lumière de nombreux bugs.

En conséquence, ces bugs sont corrigés, résultant dans une meilleure stabilité des conteneurs.

Aujourd'hui, tout fournisseur d'hébergement/cloud un peu sérieux peut lancer des conteneurs.

Les conteneurs sont devenus un super outil pour déployer/transporter des applis vers/depuis les environnements on-prem/cloud.

Docker devient un standard d'industrie

Docker atteint le jalon symbolique du 1.0

Docker est maintenant supporté par les systèmes existants comme Mesos ou Cloud Foundry.

Standardisation autour de l'OCI (Open Containers Initiative).

De nouveaux moteurs de conteneurs sont développés.

Création de la CNCF (Cloud Native Computing Foundation).

Docker devient une plate-forme

Le moteur de conteneur initial est maintenant nommé "Docker Engine".

D'autres outils y sont ajoutés:

- Docker Compose (anciennement "Fig")

- Docker Machine

- Docker Swarm

- Kitematic

- Docker Cloud (anciennement "Tutum")

- Docker Datacenter

- etc.

Docker Inc. lance ses offres commerciales.

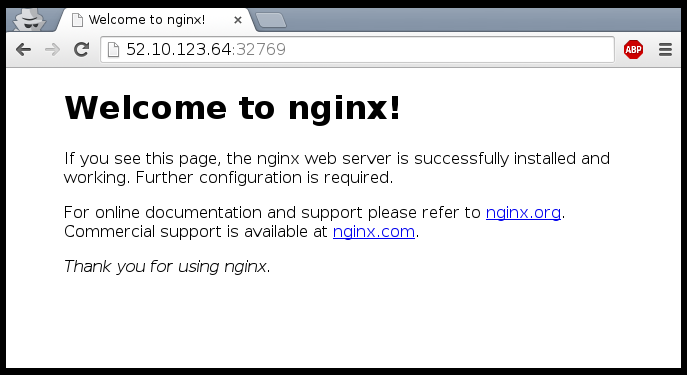

Notre environnement de formation

(automatically generated title slide)

Notre environnement de formation

Si vous assistez à un atelier ou un tutoriel:

- une VM a été provisionnée pour chaque apprenant

Si vous suivez ou révisez ce cours tout seul, vous pouvez:

installer Docker en local (comme expliqué dans le chapitre "Installer Docker")

installer Docker sur une VM dans le cloud (par ex.)

utiliser https://www.play-with-docker.com/ pour lancer en un instant un environnement de formation

containers/Training_Environment.md

Notre VM Docker

Cette section suppose que vous suivez ce cours dans le cadre d'un tutoriel, une atelier ou une formation, où chaque apprenant reçoit une VM Docker individuelle.

La VM est créée juste avant la formation.

Elle restera allumée pendant toute la durée de la formation.

Elle sera détruite peu de temps après la formation.

Elle est fournie avec Docker et quelques autres outils utiles.

containers/Training_Environment.md

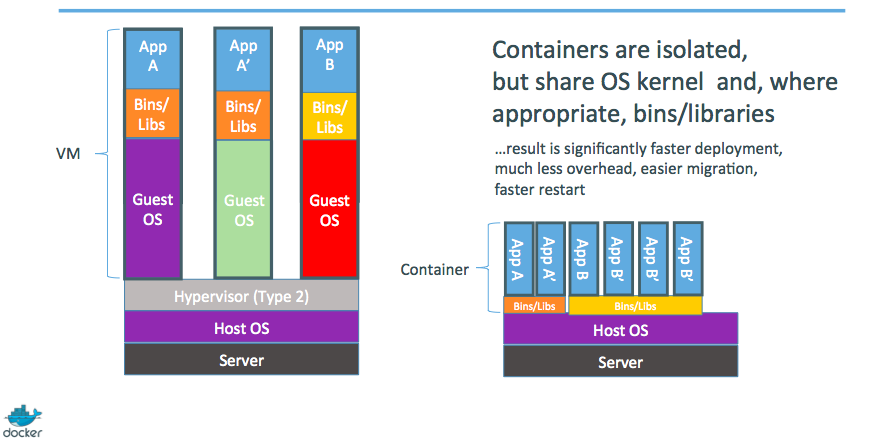

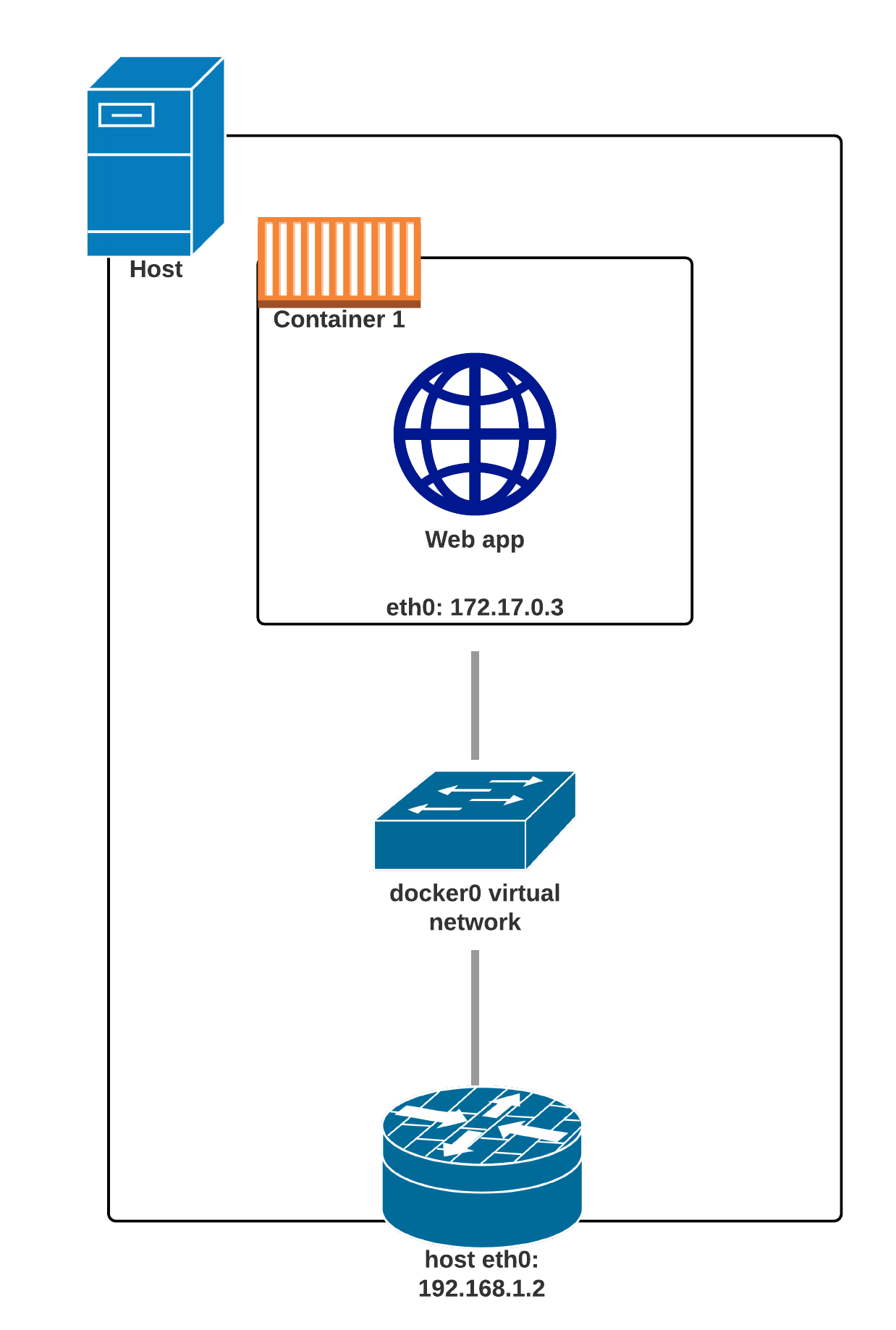

C'est quoi Docker?

"Installer Docker" signifie en vrai "Installer le Docker Engine et le client en ligne de commande".

Le Docker Engine est un daemon (un service tournant en tâche de fond).

Ce daemon gère les conteneurs, à la manière d'un hyperviseur qui gère ses VMs.

Nous dialoguons avec le Docker Engine par la Docker CLI (ligne de commande).

Docker CLI et Docker Engine communiquent via une API.

Il existe de nombreux autres programmes, et de composants client, pour exploiter cette API.

containers/Training_Environment.md

Pourquoi on ne lance pas Docker en local?

On va télécharger des images de conteneur et des paquets de distribution.

Cela pourrait quelque peu stresser la connexion WiFi locale, et nous ralentir.

Au lieu de ça, on préfère passer par une VM distante qui a une meilleure connectivité.

Dans de rares cas, installer Docker en local peut s'avérer tortueux:

pas d'accès au compte admin/root (poste géré par une DSI stricte)

CPU ou système d'exploitation 32 bits.

vieille version de l'OS (par ex. CentOS 6, OSX pré-Yosemite, Windows 7)

Il est meilleur de passer du temps à apprendre les conteneurs qu'à trifouiller l'installateur!

containers/Training_Environment.md

Se connecter à votre Machine Virtuelle

Vous avez besoin d'un client SSH.

- Sur OS X, Linux et autres systèmes UNIX,

sshsuffit:

$ ssh <login>@<ip-address>Sur Windows, si vous n'avez pas de client SSH, vous pouvez télécharger:

Putty (www.putty.org)

Git BASH (https://git-for-windows.github.io/)

MobaXterm (https://mobaxterm.mobatek.net/)

containers/Training_Environment.md

Vérifier votre Machine Virtuelle

Une fois connecté(e), assurez-vous que la commande Docker de base fonctionne:

$ docker versionClient: Version: 18.03.0-ce API version: 1.37 Go version: go1.9.4 Git commit: 0520e24 Built: Wed Mar 21 23:10:06 2018 OS/Arch: linux/amd64 Experimental: false Orchestrator: swarmServer: Engine: Version: 18.03.0-ce API version: 1.37 (minimum version 1.12) Go version: go1.9.4 Git commit: 0520e24 Built: Wed Mar 21 23:08:35 2018 OS/Arch: linux/amd64 Experimental: falseSi ça ne marche pas, levez la main et on viendra vous aider!

containers/Training_Environment.md

Nos premiers conteneurs

(automatically generated title slide)

Objectifs

À la fin de cette leçon, vous aurez:

vu Docker en action;

démarré vos premiers conteneurs.

containers/First_Containers.md

Hello World

Depuis votre environnement Docker, lancez juste la commande suivante:

$ docker run busybox echo hello worldhello world(Si votre installation Docker est vierge, quelques lignes en plus s'afficheront,

correspondant au téléchargement de l'image busybox.)

containers/First_Containers.md

C'était notre premier conteneur!

Nous avons utilisé l'une des images les plus petites et simples:

busybox.busyboxest typiquement utilisée dans les systèmes embarqués (téléphones, routeurs, etc.)Nous avons lancé un seul processus pour afficher

hello world.

containers/First_Containers.md

Un conteneur plus utile

Lançons un conteneur un peu plus excitant:

$ docker run -it ubunturoot@04c0bb0a6c07:/#C'est un conteneur tout neuf.

Il exécute un système

ubuntubasique et sans fioritures.-itest le raccourci pour-i -t.-idit à Docker de nous connecter à l'entrée du conteneur.-tdit à Docker que nous voulons un pseudo-terminal.

containers/First_Containers.md

Faire quelque chose dans notre conteneur

Essayez de lancer figlet dans notre conteneur.

root@04c0bb0a6c07:/# figlet hellobash: figlet: command not foundD'accord, donc nous allons devoir l'installer.

containers/First_Containers.md

Installer un paquet dans notre conteneur

Nous voulons figlet, alors installons-le:

root@04c0bb0a6c07:/# apt-get update...Fetched 1514 kB in 14s (103 kB/s)Reading package lists... Doneroot@04c0bb0a6c07:/# apt-get install figletReading package lists... Done...Une minute plus tard, figlet est installé!

containers/First_Containers.md

Essayons de lancer notre programme fraichement installé

Le programme figlet prend un message en paramètre.

root@04c0bb0a6c07:/# figlet hello _ _ _ | |__ ___| | | ___ | '_ \ / _ \ | |/ _ \ | | | | __/ | | (_) ||_| |_|\___|_|_|\___/Magnifique! 😍

containers/First_Containers.md

Compter les paquets dans le conteneur

Vérifions maintenant combien de paquets y sont installés.

root@04c0bb0a6c07:/# dpkg -l | wc -l190dpkg -lliste les paquets installés dans notre conteneurwc -lva les compter

Combien de paquets avons-nous sur notre hôte?

containers/First_Containers.md

Compter les paquets sur l'hôte?

Quittez le conteneur en vous déconnectant du shell, comme d'habitude.

(i.e. avec ^D ou exit)

root@04c0bb0a6c07:/# exitMaintenant, essayons de:

lancer

dpkg -l | wc -l. Combien de paquets sont installés?lancer

figlet. Est-ce que ça marche?

containers/First_Containers.md

Hôte et conteneurs sont deux systèmes indépendants

Nous avons lancé un conteneur

ubuntusur un hôte Linux/Windows/macOS.Ils possèdent des paquets indépendants et différents.

Installer quelque chose sur l'hôte ne l'expose pas dans le conteneur.

Et vice-versa.

Même si l'hôte et le conteneur ont tous deux la même distribution Linux.

Nous pouvons lancer n'importe quel conteneur sur n'importe quel hôte.

(Une exception: les conteneurs Windows ne peuvent tourner sur les machines Linux; par encore en tout cas.)

containers/First_Containers.md

Où est notre conteneur?

Notre conteneur est maintenant en état stopped.

Il existe encore sur le disque, mais toutes ses ressources ont été libérées.

Nous verrons plus tard comment récupérer ce conteneur.

containers/First_Containers.md

Démarrer un autre conteneur

Et si nous démarrions un nouveau conteneur, pour y lancer à nouveau figlet?

$ docker run -it ubunturoot@b13c164401fb:/# figletbash: figlet: command not foundNous avons lancé un tout nouveau conteneur.

Dans l'image de base Ubuntu utilisée ci-dessus,

figletest absent.

containers/First_Containers.md

Où est mon conteneur?

Pouvons nous réutiliser ce conteneur que nous avons pris le soin de personnaliser?

On pourrait, mais ce n'est pas le mode de production par défaut avec Docker.

Quel est le processus général, alos?

Toujours démarrer avec un conteneur tout nouveau.

Si on a besoin d'installer quoique ce soit dans notre conteneur, générer une nouvelle image.Ça a l'air compliqué!

Nous allons voir que c'est en fait assez simple!

Et tout ça pour quoi?

Tout ça pour appuyer sur l'automatisation et la répétabilité. Voyons voir pourquoi ...

containers/First_Containers.md

Animaux de compagnie et bétail

Dans la métaphore "pets vs cattle", il existe deux genres de serveurs.

Les animaux de compagnie (Pets):

ont un petit nom et une configuration unique

quand ils défaillent, on fait tout ce qu'on peut pour les soigner.

Le bétail (Cattle):

ont des noms génériques (par ex. contenant des numéros) et une configuration générique

leur configuration est générée par une couche de gestion de configuration, et des templates ...

quand une panne advient, on peut les remplacer immédiatement par un nouveau serveur

Quelle est la relation avec Docker et les conteneurs?

containers/First_Containers.md

Environnement de développement locaux

Avec l'usage de VMs locales (comme par ex. Virtualbox ou VMware), notre flux de travail ressemble à ce qui suit:

créer une VM à partir d'un gabarit de base (Ubuntu, CentOS...)

installer les paquets, configurer l'environnement

travail sur le projet en tant que tel

finalement, éteindre la VM

la prochaine fois qu'on aborde ce projet, redémarrer la VM dans l'état où on l'a laissée

si on a besoin de retoucher l'environnement, on le fait en direct.

Au fil du temps, la configuration de la VM évolue et diverge.

Il nous manque une procédure propre, fiable et déterministe de provisionner cet environnement.

containers/First_Containers.md

Développement local avec Docker

Avec Docker, la démarche est la suivante:

créer une image de conteneur représentant notre environnement de dév.

lancer un conteneur basé sur cette image

travailler sur notre projet proprement dit

finalement, stopper le conteneur

la prochaine fois qu'on aborde le projet, démarrer un nouveau contneeur

en cas de changement de l'environnement, on créé une nouvelle image.

Nous avons une définition claire de notre environnement, qu'on peut partager de manière fiable avec les autres.

Nous verrons dans les chapitres suivants comment préparer une image personnalisée avec

figlet.

containers/First_Containers.md

Conteneurs en tâche de fond

(automatically generated title slide)

Objectifs

Nos premiers conteneurs étaient interactifs.

Nous allons maintenant voir comment:

- Lancer un conteneur non-interactif

- Lancer un conteneur en tâche de fond.

- Lister les conteneurs en cours d'exécution.

- Vérifier les logs d'un conteneur.

- Arrêter un conteneur.

- Lister les conteneurs à l'arrêt.

containers/Background_Containers.md

Un conteneur non-interactif

Nous allons lancer un petit conteneur spécial.

Ce conteneur ne fait qu'afficher l'heure à chaque seconde.

$ docker run jpetazzo/clockFri Feb 20 00:28:53 UTC 2015Fri Feb 20 00:28:54 UTC 2015Fri Feb 20 00:28:55 UTC 2015...- Ce conteneur va tourner indéfiniment.

- Pour l'arrêter, appuyer sur

^C. - Docker a automatiquement téléchargé l'image

jpetazzo/clock. - Cette image est une image utilisateur, créée par

jpetazzo. - Nous en apprendrons plus sur les images utilisateur (et autres types d'images) plus tard.

containers/Background_Containers.md

Lancer un conteneur en tâche de fond

Les conteneurs peuvent être démarrés en tâche de fond, avec l'option -d (mode daemon)

$ docker run -d jpetazzo/clock47d677dcfba4277c6cc68fcaa51f932b544cab1a187c853b7d0caf4e8debe5ad- Nous ne voyons pas l'affichage du conteneur.

- Mais pas de souci: Docker collecte tout affichage et l'écrit dans un log!

- Docker nous retourne un identifiant (ID) du conteneur.

containers/Background_Containers.md

Lister les conteneurs en cours d'exécution

Comment vérifier que notre conteneur est encore lancé?

Avec docker ps, tout comme la commande ps d'UNIX, qui liste les processus qui tournent.

$ docker psCONTAINER ID IMAGE ... CREATED STATUS ...47d677dcfba4 jpetazzo/clock ... 2 minutes ago Up 2 minutes ...Docker nous indique:

- l'ID (tronqué) de notre conteneur;

- l'image utilisée pour démarrer le conteneur;

- que notre conteneur est lancé (

Up) depuis quelques minutes; - d'autres informations (COMMAND, PORTS, NAME) que nous verrons plus tard.

containers/Background_Containers.md

Lancer plus de conteneurs

Démarrons deux autres conteneurs.

$ docker run -d jpetazzo/clock57ad9bdfc06bb4407c47220cf59ce21585dce9a1298d7a67488359aeaea8ae2a$ docker run -d jpetazzo/clock068cc994ffd0190bbe025ba74e4c0771a5d8f14734af772ddee8dc1aaf20567dVérifiez que docker ps mentionne correctement tous les 3 conteneurs.

containers/Background_Containers.md

Afficher uniquement le dernier conteneur démarré

Quand de nombreux conteneurs tournent déjà, il peut être utile de limiter l'affichage au dernier conteneur démarré.

C'est à ça que sert l'option -l ("Last"):

$ docker ps -lCONTAINER ID IMAGE ... CREATED STATUS ...068cc994ffd0 jpetazzo/clock ... 2 minutes ago Up 2 minutes ...containers/Background_Containers.md

Voir uniquement les IDs des conteneurs

Plusieurs commandes Docker sont basées sur des IDs de conteneurs: docker stop, docker rm, etc.

Si nous voulons lister uniquement les IDs de nos conteneurs (sans les autres colonnes ni en-tête),

nous pouvons utiliser l'option -q ("Quiet", "Quick"):

$ docker ps -q068cc994ffd057ad9bdfc06b47d677dcfba4containers/Background_Containers.md

Combinaison d'options

Nous pouvons combiner -l et -q pour uniquement voir l'ID du dernier conteneur démarré:

$ docker ps -lq068cc994ffd0A première vue, cela parait vraiment utile dans le cadre de scripts.

Toutefois, si nous voulons démarrer un conteneur et récupérer son ID de manière sécurisée,

il est plus conseillé d'utiliser docker run -d, ce que nous aborderons dans un instant.

(Using docker ps -lq is prone to race conditions: what happens if someone

else, or another program or script, starts another container just before

we run docker ps -lq?)

containers/Background_Containers.md

Voir les logs d'un conteneur

On vous a dit que Docker enregistrait l'affichage d'un conteneur.

C'est le moment d'en parler.

$ docker logs 068Fri Feb 20 00:39:52 UTC 2015Fri Feb 20 00:39:53 UTC 2015...- Nous avons spécifié un préfixe de l'ID d'un conteneur.

- On peut, bien sûr, utiliser l'ID complet.

- La commande

logsva afficher les logs complets du conteneur.

(Parfois, c'est bien trop. Voyons comment gérer ça.)

containers/Background_Containers.md

Afficher uniquement la fin des logs

Pour éviter de se faire spammer avec des dizaines de pages d'infos,

on peut utiliser l'option --tail:

$ docker logs --tail 3 068Fri Feb 20 00:55:35 UTC 2015Fri Feb 20 00:55:36 UTC 2015Fri Feb 20 00:55:37 UTC 2015- Le paramètre est le nombre de lignes que nous voulons afficher.

containers/Background_Containers.md

Suivre les logs en temps réel

Tout comme la commande UNIX standard tail -f, on peut

suivre les logs de notre conteneur:

$ docker logs --tail 1 --follow 068Fri Feb 20 00:57:12 UTC 2015Fri Feb 20 00:57:13 UTC 2015^C- Cela affichera la dernière ligne du fichier log

- Puis, l'affichage continuera de se mettre à jour en temps réel.

- Pour sortir, appuyer sur

^C.

containers/Background_Containers.md

Arrêter notre conteneur

Il y a deux façons de stopper notre conteneur détaché;

- Le tuer via la commande

docker kill. - Le stopper via la commande

docker stop.

La première arrête le conteneur immédiatement, en utilisant

le signal KILL.

La seconde est plus douce. Elle envoie un signal TERM, et

après 10 secondes, si le conteneur n'est pas arrêté,

il envoie KILL.

Rappel: le signal KILL ne peut être intercepté, et terminera

le conteneur de force.

containers/Background_Containers.md

Arrêter nos conteneurs

Essayons d'arrêter un de ces conteneurs:

$ docker stop 47d647d6Cela va prendre 10 secondes:

- Docker envoie le signal TERM;

- le conteneur ne réagit pas à ce signal (c'est un simple script Shell sans gestion de signal spécifique);

- 10 secondes plus tard, puisque le conteneur est toujours actif, Docker envoie le signal KILL;

- ceci neutralise le conteneur.

containers/Background_Containers.md

Supprimer le reste des conteneurs

Soyons moins patient avec les deux autres conteneurs:

$ docker kill 068 57ad06857adLes commandes stop et kill acceptent plusieurs IDs de conteneurs.

Ces conteneurs seront supprimés immédiatement (sans le délai de 10 secondes).

Vérifions que nos conteneurs ne s'affichent plus:

$ docker pscontainers/Background_Containers.md

Lister les conteneurs arrêtés

Nous pouvons aussi afficher les conteneurs stoppés, avec l'option -a (--all).

$ docker ps -aCONTAINER ID IMAGE ... CREATED STATUS068cc994ffd0 jpetazzo/clock ... 21 min. ago Exited (137) 3 min. ago57ad9bdfc06b jpetazzo/clock ... 21 min. ago Exited (137) 3 min. ago47d677dcfba4 jpetazzo/clock ... 23 min. ago Exited (137) 3 min. ago5c1dfd4d81f1 jpetazzo/clock ... 40 min. ago Exited (0) 40 min. agob13c164401fb ubuntu ... 55 min. ago Exited (130) 53 min. agocontainers/Background_Containers.md

Comprendre les images Docker

(automatically generated title slide)

Objectifs

Dans cette section, nous expliquerons:

Ce qu'est une image;

Ce qu'est un layer;

Les différents nommages d'image;

Comment chercher et télécharger des images;

Les tags d'image et quand les utiliser.

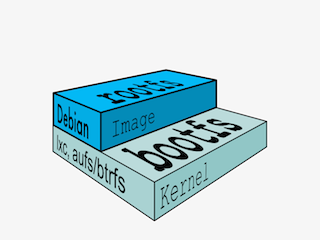

Qu'est-ce qu'une image?

Image = fichiers + méta-données

Ces fichiers forment le système de fichier racine de notre conteneur.

Les méta-données indiquent un nombre de choses, comme:

- l'auteur de l'image

- la commande à exécuter dans le conteneur au démarrage

- les variables d'environnement à initialiser

- etc.

Des couches composent les images, appelées layers, empilées les unes au-dessus des autres.

Chaque couche peut ajouter, modifier, supprimer des fichiers ou des méta-données.

Les layers sont partagés entre images pour optimiser l'usage du disque, les temps de transfert et la consommation mémoire.

Exemple d'une web app Java

Chaque des points suivants se traduira par un layer:

- couche de base CentOS

- Paquets et fichier de configuration fournis par le service informatique interne

- JRE

- Tomcat

- Dépendances de notre application

- Code et sources de notre application

- Configuration de notre appli

Différences entre conteneurs et images

Une image est un système de fichiers en lecture seule.

Un conteneur est un ensemble de processus encapsulé dans une copie en lecture/écriture de ce système de fichiers.

Pour optimiser le temps de démarrage du conteneur, on fait du copy-on-write au lieu d'une copie traditionnelle.

docker rundémarre un conteneur depuis une image donnée.

Comparaison avec la programmation orientée objet

Conceptuellement, les images sont proches des classes.

Conceptuellement, les layers sont proches de l'héritage.

Conceptuellement, les conteneurs sont proches des instances.

Attends un peu...

Si une image est en lecture-seule, comment on la change?

On ne la change pas.

On lance un nouveau conteneur à partir de cette image.

Puis on apporte des modifications à ce conteneur.

Quand on a fini, nous les figeons dans un nouveau layer.

Une nouvelle image est créée en empilant la nouvelle couche au-dessus de l'ancienne image.

Le problème de l'oeuf et la poule

La seule façon de créer une image est de geler un conteneur.

La seule façon de créer un conteneur est d'instancier une image.

A l'aide!

Créer les premières images

Il existe une image spéciale vide, appelée scratch.

- Elle permet de générer une image de zéro.

La commande docker import charge un fichier tarball dans Docker.

- L'image importée devient une image indépendante.

- Cette nouvelle image a un seul layer.

Note: vous n'aurez sans doute jamais à faire cela vous-même.

Créer d'autres images

docker commit

- Enregistre tous les changements d'un conteneur dans un nouveau layer.

- Génère une nouvelle image (en réalité une copie du conteneur).

docker build (utilisé 99% du temps)

- Exécute une séquence répétable de construction.

- C'est la méthode recommandée!

Nous expliquerons les deux méthodes dans un moment.

Images et espaces de nommage

Il existe trois espaces de nommage (namespaces):

Images officielles:

par ex.

ubuntu,busybox, etc.Images d'utilisateurs (et organisations):

par ex.

jpetazzo/clockImages auto hébergées

par ex.

registry.example.com:5000/mon-image/privee

Examinons chacun d'entre eux.

Espace de nom 'racine'

L'espace de nom racine est pour les images officielles. Elles y sont placées par Docker Inc., mais sont généralement écrites et maintenues par des tierces parties.

Ces images incluent:

De petites images "couteau suisse", telles busybox.

Des images de distributions Linux servant de base aux builds, comme ubuntu, fedora, etc.

Des services et composants prêts à l'emploi, comme redis, postgresql, etc.

Plus de 150 à ce jour!

Espace de nommage utilisateur

L'espace de nommage pour utilisateur contient les images dans Docker Hub fournies par les utilisateurs et organisations.

Par exemple:

jpetazzo/clockL'utilisateur Docker Hub est:

jpetazzoLe nom de l'image est:

clockEspace de nommage auto-hébergé

Cet espace de nommage contient les images qui ne sont pas hébergées sur Docker Hub, mais sur des registres de tierce partie.

Ils contiennent le nom de serveur (ou adresse IP), et le port (en option), du serveur de registre.

Par exemple:

localhost:5000/wordpresslocalhost:5000est l'hôte et le port du registrewordpressest le nom de cette image

Other examples:

quay.io/coreos/etcdgcr.io/google-containers/hugoComment gérer et stocker les images?

On stocke les images:

- sur votre hôte Docker.

- dans un registre Docker.

Vous pouvez utiliser le client Docker pour télécharger (pull) ou téléverser (push) des images.

Pour être plus précis: vous pouvez utiliser le client Docker pour intimer au Docker Engine de push et pull des images vers/depuis un registre.

Afficher les images actuelles

Voyons quelles sont les images disponibles sur notre serveur.

$ docker imagesREPOSITORY TAG IMAGE ID CREATED SIZEfedora latest ddd5c9c1d0f2 3 days ago 204.7 MBcentos latest d0e7f81ca65c 3 days ago 196.6 MBubuntu latest 07c86167cdc4 4 days ago 188 MBredis latest 4f5f397d4b7c 5 days ago 177.6 MBpostgres latest afe2b5e1859b 5 days ago 264.5 MBalpine latest 70c557e50ed6 5 days ago 4.798 MBdebian latest f50f9524513f 6 days ago 125.1 MBbusybox latest 3240943c9ea3 2 weeks ago 1.114 MBtraining/namer latest 902673acc741 9 months ago 289.3 MBjpetazzo/clock latest 12068b93616f 12 months ago 2.433 MBChercher des images

Nous ne pouvons lister toutes les images sur un registre distant, mais nous pouvons chercher un mot-clé spécifique:

$ docker search marathonNAME DESCRIPTION STARS OFFICIAL AUTOMATEDmesosphere/marathon A cluster-wide init and co... 105 [OK]mesoscloud/marathon Marathon 31 [OK]mesosphere/marathon-lb Script to update haproxy b... 22 [OK]tobilg/mongodb-marathon A Docker image to start a ... 4 [OK]"Stars" mesure la popularité de l'image.

"Official" concerne les images qui sont dans le namespace racine.

"Automated" indique que l'image est générée automatiquement par le Docker Hub.

(Cela signifie que leur recette de construction est toujours disponible.)

Télécharger des images

Il y a deux façons de récupérer des images.

Explicite, avec

docker pull.Implicite, en lançant

docker runet l'image n'est pas disponible en local.

Télécharger une image via pull

$ docker pull debian:jessiePulling repository debianb164861940b8: Download completeb164861940b8: Pulling image (jessie) from debiand1881793a057: Download completeComme vu précédemment, les images sont faites de layers.

Docker a téléchargé tous les layers nécessaires.

Dans notre exemple,

:jessieindique quelle version exacte de Debian nous voulons.

C'est un tag (étiquette) de version.

Images et tags

On peut associer des tags aux images.

C'est utile pour préciser les versions ou variantes d'une image.

docker pull ubuntuva se référer àubuntu:latest.Le tag

latestest par tradition mis à jour fréquemment.

Quand utiliser (et ne pas utiliser) les tags

Pas besoin de spécifier d'étiquette (tag) pour:

- des tests ou prototypes rapides.

- expérimenter.

- récupérer la dernière version.

Utiliser des tags pour:

- Persister une procédure dans un script;

- Déployer en production;

- Garantir que la même version sera utilisée partout;

- Garantir la répétabilité future.

This is similar to what we would do with pip install, npm install, etc.

Résumé du chapitre

Nous avons appris comment:

- Comprendre les images et layers;

- Fonctionne les espaces de nom dans Docker;

- Chercher et télécharger des images.

Construire des images Docker avec un Dockerfile

(automatically generated title slide)

Construire des images Docker avec un Dockerfile

containers/Building_Images_With_Dockerfiles.md

Objectifs

Nous allons construire une image de conteneur automatiquement, grâce au Dockerfile.

A la fin de cette leçon, vous saurez comment:

Ecrire un

Dockerfile.Générer une image (build) via un

Dockerfile.

containers/Building_Images_With_Dockerfiles.md

Aperçu d'un Dockerfile

Un

Dockerfileest une recette de construction pour une image Docker.Il contient une série d'instructions indiquant à Docker comment l'image est construite.

La commande

docker buildgénère une image à partir d'unDockerfile.

containers/Building_Images_With_Dockerfiles.md

Ecrire notre premier Dockerfile

Notre Dockerfile doit être dans un dossier nouveau et vide.

- Ajouter un nouveau dossier pour accueillir notre

Dockerfile.

$ mkdir myimage- Créer un fichier

Dockerfileà l'intérieur de ce nouveau dossier.

$ cd myimage$ vim DockerfileBien sûr, vous pouvez utiliser n'importe quel éditeur de votre choix.

containers/Building_Images_With_Dockerfiles.md

Entrez ces lignes dans notre Dockerfile...

FROM ubuntuRUN apt-get updateRUN apt-get install figletFROMindique notre image de base pour notre build.Chaque ligne

RUNsera exécutée par Docker pendant le build.Nos commandes

RUNdoivent être non-interactive.

(Aucune entrée ne peut être fournie à Docker pendant le build).Dans bien des cas, nous ajouterons l'option

-yàapt-get.

containers/Building_Images_With_Dockerfiles.md

Construisons-la!

Enregistrez notre fichier, et lancez:

$ docker build -t figlet .-tindique le tag à appliquer à l'image..indique la localisation du build context.

Nous parlerons en détails du build context plus tard.

Pour garder les choses simples: c'est le dossier où se trouve notre Dockerfile.

containers/Building_Images_With_Dockerfiles.md

Que se passe-t-il quand nous générons l'image?

L'affichage de docker build ressemble à ceci:

docker build -t figlet .Sending build context to Docker daemon 2.048kBStep 1/3 : FROM ubuntu ---> f975c5035748Step 2/3 : RUN apt-get update ---> Running in e01b294dbffd(...output of the RUN command...)Removing intermediate container e01b294dbffd ---> eb8d9b561b37Step 3/3 : RUN apt-get install figlet ---> Running in c29230d70f9b(...output of the RUN command...)Removing intermediate container c29230d70f9b ---> 0dfd7a253f21Successfully built 0dfd7a253f21Successfully tagged figlet:latest- L'affichage des commandes

RUNa été omis. - Voyons voir en quoi consiste cet affichage.

containers/Building_Images_With_Dockerfiles.md

Envoi du build context à Docker

Sending build context to Docker daemon 2.048 kBLe build context est le dossier

.donné àdocker build.Il est envoyé (sous forme d'archive) par le client Docker au daemon Docker.

Cela permet d'utiliser un serveur distant pour le build utilisant des fichiers locaux.

Soyez attentifs (ou patient) si ce dossier est lourd et votre connexion est lente.

You can speed up the process with a

.dockerignorefileIt tells docker to ignore specific files in the directory

Only ignore files that you won't need in the build context!

containers/Building_Images_With_Dockerfiles.md

Exécution de chaque étape

Step 2/3 : RUN apt-get update ---> Running in e01b294dbffd(...output of the RUN command...)Removing intermediate container e01b294dbffd ---> eb8d9b561b37Un container (

e01b294dbffd) est créé à partir de l'image de base.La commande

RUNse lance dans ce container.Le conteneur est sauvé dans une nouvelle image (

eb8d9b561b37)Le conteneur de build (

e01b294dbffd) est supprimé.Le résultat de cette étape sera l'image de base pour la prochaine commande.

containers/Building_Images_With_Dockerfiles.md

Le système de cache

Si vous lancez le même build de nouveau, ce sera instantané. Pourquoi?

Après chaque étape de build, Docker prend un snapshot de l'image résultante.

Avant chaque nouvelle étape, Docker vérifie si la même séquence a été générée.

Docker utilise les chaines de caractères exactes définies dans votre

Dockerfile, donc:RUN apt-get install figlet cowsay

est différent de

RUN apt-get install cowsay figletRUN apt-get updaten'est pas exécuté, quand les miroirs sont mis à jour.

Vous pouvez forcer un nouveau build avec docker build --no-cache....

containers/Building_Images_With_Dockerfiles.md

Lancer l'image

L'image résultante n'est pas différente de celle définie manuellement.

$ docker run -ti figletroot@91f3c974c9a1:/# figlet hello _ _ _ | |__ ___| | | ___ | '_ \ / _ \ | |/ _ \ | | | | __/ | | (_) ||_| |_|\___|_|_|\___/Youpi! 🎉

containers/Building_Images_With_Dockerfiles.md

Utiliser l'image et afficher l'historique

La commande history liste toutes les couches composant une image.

Pour chaque couche (layer), on voit la date de création, sa taille et la commande utilisée.

Quand une image est générée via un Dockerfile, chaque layer correspond à une ligne du Dockerfile.

$ docker history figletIMAGE CREATED CREATED BY SIZEf9e8f1642759 About an hour ago /bin/sh -c apt-get install fi 1.627 MB7257c37726a1 About an hour ago /bin/sh -c apt-get update 21.58 MB07c86167cdc4 4 days ago /bin/sh -c #(nop) CMD ["/bin 0 B<missing> 4 days ago /bin/sh -c sed -i 's/^#\s*\( 1.895 kB<missing> 4 days ago /bin/sh -c echo '#!/bin/sh' 194.5 kB<missing> 4 days ago /bin/sh -c #(nop) ADD file:b 187.8 MBcontainers/Building_Images_With_Dockerfiles.md

Introduction à la syntaxe JSON

La plupart des arguments de Dockerfile peuvent être passés sous deux formes:

chaine simple:

RUN apt-get install figletliste JSON:

RUN ["apt-get", "install", "figlet"]

Nous allons changer notre Dockerfile et voir comment cela affecte l'image résultante.

containers/Building_Images_With_Dockerfiles.md

Usage de la syntaxe JSON dans notre Dockerfile

Changeons notre Dockerfile comme suit:

FROM ubuntuRUN apt-get updateRUN ["apt-get", "install", "figlet"]Puis relançons un build du nouveau Dockerfile.

$ docker build -t figlet .containers/Building_Images_With_Dockerfiles.md

Syntaxe JSON vs syntaxe simple

Comparons le nouvel historique:

$ docker history figletIMAGE CREATED CREATED BY SIZE27954bb5faaf 10 seconds ago apt-get install figlet 1.627 MB7257c37726a1 About an hour ago /bin/sh -c apt-get update 21.58 MB07c86167cdc4 4 days ago /bin/sh -c #(nop) CMD ["/bin 0 B<missing> 4 days ago /bin/sh -c sed -i 's/^#\s*\( 1.895 kB<missing> 4 days ago /bin/sh -c echo '#!/bin/sh' 194.5 kB<missing> 4 days ago /bin/sh -c #(nop) ADD file:b 187.8 MBLa syntaxe JSON spécifie une commande exacte à exécuter.

La syntaxe simple spécifie une commande à être encapsulée dans

/bin/sh -c "...".

containers/Building_Images_With_Dockerfiles.md

Quand utiliser la syntaxe JSON et la syntaxe simple

La syntaxe simple:

- est plus facile à écrire

- extrapole les variables d'environnement et d'autres expressions de shell

- crée un processus supplémentaire (

/bin/sh -c ...) pour interpréter la commande - exige l'existence de

/bin/shdans le conteneur

La syntaxe JSON:

- est plus longue à écrire (et à lire!)

- passe tous les arguments sans interprétation

- n'ajoute pas de processus supplémentaire

- ne requiert pas l'existence de

/bin/shdans le conteneur

containers/Building_Images_With_Dockerfiles.md

CMD et ENTRYPOINT

(automatically generated title slide)

Objectifs

Dans cette leçon, nous verrons deux instructions

importantes du Dockerfile:

CMD et ENTRYPOINT.

Ces instructions nous permettent de déclarer la commande par défaut à lancer dans un conteneur.

containers/Cmd_And_Entrypoint.md

Définir une commande par défaut

Quand quelqu'un lancera notre conteneur, nous voulons le saluer avec un sympathique bonjour, et une fonte spéciale.

Pour ça, nous allons lancer:

figlet -f script hello-f scriptdit à figlet d'utiliser une fonte spécifique.helloest le message que nous voulons afficher.

containers/Cmd_And_Entrypoint.md

Ajouter CMD à notre Dockerfile

Notre nouveau Dockerfile aura cet aspect:

FROM ubuntuRUN apt-get updateRUN ["apt-get", "install", "figlet"]CMD figlet -f script helloCMDdéfinit une commande par défaut à lancer quand aucune n'est précisée.Elle peut apparaître n'importe où dans le fichier.

Chaque

CMDannulera et remplacera la précédente.Par conséquent, même si vous pouvez utiliser plusieurs fois

CMD, c'est inutile au final.

containers/Cmd_And_Entrypoint.md

Générer et tester notre image

Essayons de lancer un build:

$ docker build -t figlet ....Successfully built 042dff3b4a8dSuccessfully tagged figlet:latestEt de le lancer:

$ docker run figlet _ _ _ | | | | | | | | _ | | | | __ |/ \ |/ |/ |/ / \_| |_/|__/|__/|__/\__/containers/Cmd_And_Entrypoint.md

Surcharger CMD

Si nous voulons ouvrir un shell dans notre conteneur (au lieu de

lancer figlet), il suffit de spécifier un autre programme à lancer:

$ docker run -it figlet bashroot@7ac86a641116:/#On a indiqué

bashIl a remplacé la valeur de

CMD

containers/Cmd_And_Entrypoint.md

Utiliser ENTRYPOINT

Nous voulons être capable de spécifier un message différent en ligne de commande,

tout en gardant figlet et quelques paramètres par défaut.

Autrement dit, on aimerait taper quelque chose comme:

$ docker run figlet salut _ | | , __, | | _|_ / \_/ | |/ | | | \/ \_/|_/|__/ \_/|_/|_/Nous utiliserons pour ça l'instruction ENTRYPOINT du Dockerfile.

containers/Cmd_And_Entrypoint.md

Ajouter ENTRYPOINT à notre Dockerfile

Notre nouveau Dockerfile aura cet aspect:

FROM ubuntuRUN apt-get updateRUN ["apt-get", "install", "figlet"]ENTRYPOINT ["figlet", "-f", "script"]ENTRYPOINTdéfinit une commande de base (et ses paramètres) pour le conteneur.Les arguments en ligne de commande sont ajoutés aux paramètres ci-dessus.

Tout comme

CMD,ENTRYPOINTpeut apparaître n'importe où, et remplacera la valeur précédente.

Pourquoi avoir utilisé la syntaxe JSON pour notre ENTRYPOINT?

containers/Cmd_And_Entrypoint.md

Implications des syntaxes JSON vs simple

Quand CMD ou ENTRYPOINT utilisent la syntaxe simple, ils sont encapsulés dans

sh -cPour éviter ce comportement, on peut utiliser la syntaxe JSON.

Et qu'est-ce qu'il se passerait avec une syntaxe simple dans ENTRYPOINT?

$ docker run figlet salutOn obtiendrait la commande suivante dans l'image figlet:

sh -c "figlet -f script" salutcontainers/Cmd_And_Entrypoint.md

Générer et tester notre image

Lançons un build:

$ docker build -t figlet ....Successfully built 36f588918d73Successfully tagged figlet:latestExécutons là:

$ docker run figlet salut _ | | , __, | | _|_ / \_/ | |/ | | | \/ \_/|_/|__/ \_/|_/|_/containers/Cmd_And_Entrypoint.md

Usage conjoint de CMD et ENTRYPOINT

Et si nous voulions définir un message par défaut pour notre conteneur?

Alors nous utiliserions ENTRYPOINT et CMD ensemble.

ENTRYPOINTva définir la commande de base pour notre conteneur.CMDdéfinira les paramètres par défaut pour cette commande.

Ils doivent tous les deux utiliser la syntaxe JSON.

containers/Cmd_And_Entrypoint.md

CMD et ENTRYPOINT ensemble

Notre nouveau Dockerfile a cette tête:

FROM ubuntuRUN apt-get updateRUN ["apt-get", "install", "figlet"]ENTRYPOINT ["figlet", "-f", "script"]CMD ["hello world"]ENTRYPOINTdéfinit une commande de base (et ses paramètres) pour le conteneur.Si nous ne spécifions aucun argument supplémentaire au lancement du conteneur, la valeur de

CMDy est ajoutée.Autrement, nos arguments supplémentaires de ligne de commande remplacent

CMD.

containers/Cmd_And_Entrypoint.md

Générer et tester notre image

Lançons un build:

$ docker build -t myfiglet ....Successfully built 6e0b6a048a07Successfully tagged myfiglet:latestExécutons-là sans paramètres:

$ docker run myfiglet _ _ _ _ | | | | | | | | | | | _ | | | | __ __ ,_ | | __| |/ \ |/ |/ |/ / \_ | | |_/ \_/ | |/ / | | |_/|__/|__/|__/\__/ \/ \/ \__/ |_/|__/\_/|_/containers/Cmd_And_Entrypoint.md

Surcharger les paramètres par défaut de l'image

Maintenant, passons des arguments supplémentaires à l'image.

$ docker run myfiglet hola mundo _ _ | | | | | | | __ | | __, _ _ _ _ _ __| __ |/ \ / \_|/ / | / |/ |/ | | | / |/ | / | / \_| |_/\__/ |__/\_/|_/ | | |_/ \_/|_/ | |_/\_/|_/\__/Nous avons surchargé CMD tout en gardant ENTRYPOINT.

containers/Cmd_And_Entrypoint.md

Surcharger ENTRYPOINT

Et si nous voulons lancer un shell dans notre conteneur?

On ne peut pas juste taper docker run figlet bash car

ça dirait juste à figlet d'afficher le mot "bash".

On utilise donc le paramètre --entrypoint:

$ docker run -it --entrypoint bash myfigletroot@6027e44e2955:/#containers/Cmd_And_Entrypoint.md

Copier des fichiers pendant le build

(automatically generated title slide)

Objectifs

Jusqu'ici, nous avons installé des choses dans nos images de conteneurs en téléchargeant des paquets.

Nous pouvons aussi copier des fichiers depuis le build context vers le conteneur que nous générons.

Rappel: le build context est le dossier qui contient le Dockerfile.

Dans ce chapitre, nous apprendrons une nouvelle instruction du Dockerfile: COPY.

containers/Copying_Files_During_Build.md

Compilons du code C

Nous voulons construire un conteneur qui compile un simple programme "Hello world" écrit en C.

Voici le programme, hello.c:

int main () { puts("Hello, world!"); return 0;}Ouvrons un nouveau dossier, et plaçons ce fichier à l'intérieur.

Nous écrirons ensuite le Dockerfile.

containers/Copying_Files_During_Build.md

Le Dockerfile

Sur Debian et Ubuntu, le paquet build-essential nous donnera un compilateur.

En l'installant, n'oubliez pas de spécifier l'option -y, ou sinon le build échouera

(puisque cette phase ne peut pas être intéractive).

Puis nous allons utiliser COPY pour placer le fichier source dans le conteneur.

FROM ubuntuRUN apt-get updateRUN apt-get install -y build-essentialCOPY hello.c /RUN make helloCMD /helloEcrivez ce Dockerfile.

containers/Copying_Files_During_Build.md

Tester notre programme C

Créez les fichiers

hello.cetDockerfiledans le même dossier.Lancer

docker build -t hello .dans ce dossier.Lancer

docker run hello, vous devriez voirHello, world!.

Victoire!

containers/Copying_Files_During_Build.md

COPY et le cache de build

Lancez le build encore.

Maintenant, modifiez

hello.cet lancer le build encore.Docker peut mettre en cache les étapes impliquant

COPY.Ces étapes ne seront pas exécutées si les fichiers n'ont pas changé.

containers/Copying_Files_During_Build.md

Détails

On peut

COPYdes dossiers complets en récursif.D'anciens Dockerfiles peuvent aussi comporter l'instruction

ADD.

C'est similaire sauf qu'il peut aussi extraire des archives automatiquement.Si nous voulions vraiment compiler le code C dans le conteneur, nous aurions:

copié le source dans un dossier différent, via l'instruction

WORKDIR.ou mieux encore, utilisé l'image officielle

gcc.

containers/Copying_Files_During_Build.md

Réduire la taille de l'image

(automatically generated title slide)

Réduire la taille de l'image

Dans notre précédent exemple, notre image finale contenait:

notre programme

helloson code source

le compilateur

Seul le premier élément est strictement nécessaire.

Nous allons voir comment obtenir une image sans les composants superflus.

containers/Multi_Stage_Builds.md

Ne pouvons-nous pas retirer les fichiers superflus avec RUN?

Que se passe-t-il si nous utilisons une des commandes suivantes?

RUN rm -rf ...RUN apt-get remove ...RUN make clean ...

Ne pouvons-nous pas retirer les fichiers superflus avec RUN?

Que se passe-t-il si nous utilisons une des commandes suivantes?

RUN rm -rf ...RUN apt-get remove ...RUN make clean ...

Cela ajoute une couche qui supprime un tas de fichiers.

Mais les couches précédentes (qui ont ajouté les fichiers) existent toujours.

containers/Multi_Stage_Builds.md

Retirer les fichiers avec un layer en plus

En téléchargeant une image, tous les layers doivent être récupérés.

| Instruction Dockerfile | Taille du layer | Taille de l'image |

|---|---|---|

FROM ubuntu |

Taille de l'image de base | Taille de l'image de base |

... |

... | Somme de cette couche + toutes les précédentes |

RUN apt-get install somepackage |

Taille des fichiers ajoutés (e.g. qqes Mo) |

Somme de cette couche + toutes les couches précédentes |

... |

... | idem |

RUN apt-get remove somepackage |

Env. zéro (méta-données seules) |

Identique à la précédente |

En conséquence, RUN rm ne réduit pas la taille de l'image, ni ne libère d'espace disque.

containers/Multi_Stage_Builds.md

Supprimer les fichiers inutiles

Des techniques variées sont disponibles pour obtenir des images plus petites:

dégonflement de layers,

ajouter des binaires qui sont générés hors du Dockerfile,

aplatir l'image finale,

les builds multi-stage, à multiples étapes.

Passons-les en revue rapidement.

containers/Multi_Stage_Builds.md

Dégonflement de layers

Vous verrez souvent des Dockerfiles comme suit:

FROM ubuntuRUN apt-get update && apt-get install xxx && ... && apt-get remove xxx && ...Ou la variante plus lisible:

FROM ubuntuRUN apt-get update \ && apt-get install xxx \ && ... \ && apt-get remove xxx \ && ...Cette commande RUN nous retourne une seule couche.

Les fichiers qui y sont ajoutés, puis supprimés dans le même layer, n'augmentent pas sa taille.

containers/Multi_Stage_Builds.md

Dégonflement de layers : pour et contre

Pour:

fonctionne sur toutes les versions de Docker

n'exige pas d'outils spéciaux

Contre:

pas très lisible

quelques fichiers inutiles pourraient subsister si le nettoyage n'était pas assez poussé

ce layer est coûteux (lent à générer)

containers/Multi_Stage_Builds.md

Compiler les binaires hors du Dockerfile

Cela résulte dans un Dockerfile qui ressemble à ça:

FROM ubuntuCOPY xxx /usr/local/binBien sûr, cela suppose que le fichier xxx existe déjà dans le build context.

Ce fichier doit exister avant de lancer docker build.

Par exemple, il peut:

- exister dans le dépôt du code,

- être créé par un autre outil (script, Makefile...),

- être créé par un autre conteneur puis extrait depuis l'image.

Voir par exemple l'image officielle busybox ou cette image busybox plus ancienne.

containers/Multi_Stage_Builds.md

Compiler les binaires en dehors: pour et contre

Pour:

- l'image finale peut être très petite

Contre:

exige un outil de build supplémentaire

nous retombons dans l'enfer des dépendances et le "ça-marche-sur-mon-poste"

Contre, si le binaire est ajouté au dépôt de code:

brise la portabilité entre différentes plate-formes

augmente largement la taille du dépôt si le binaire est souvent mis à jour

containers/Multi_Stage_Builds.md

Aplatir l'image finale

L'idée est de transformer l'image finale en une image à un seul layer.

Cela peut être réalisé de deux manières (au moins).

- Activer les fonctions expérimentales et aplatir l'image finale:docker image build --squash ...

- Exporter/importer l'image finale.docker build -t temp-image .docker run --entrypoint true --name temp-container temp-imagedocker export temp-container | docker import - final-imagedocker rm temp-containerdocker rmi temp-image

containers/Multi_Stage_Builds.md

Aplatir l'image finale: pour et contre

Pour:

les images à layer unique sont plus légères et rapides à télécharger

les fichiers supprimés ne prennent plus de place ni de ressources réseau.

Contre:

nous devons quand même activement supprimer les fichiers inutiles;

aplatir une image peut prendre beaucoup de temps (pour les plus grosses images)

aplatir est une opération qui annule le cache

(ne changer ne serait-ce qu'un petit fichier, et toute l'image doit être aplatie de nouveau)

containers/Multi_Stage_Builds.md

Builds multi-stage

Un build multi-stage nous permet d'indiquer plusieurs étapes d'images.

Chaque étape constitue une image séparée, et peut copier les fichiers des images précédentes.

Nous allons voir comment ça marche plus en détail.

containers/Multi_Stage_Builds.md

Builds multi-stage

(automatically generated title slide)

Builds multi-stage

A tout moment dans notre

Dockerfile, nous pouvons ajouter une ligneFROM.Cette ligne démarre une nouvelle étape dans notre build.

Chaque étape peut accéder aux fichiers des étapes précédentes avec

COPY --from=....Quand un build est étiqueté (avec

docker build -t ...), c'est la dernière étape qui récupère le tag.Les étapes précédentes ne sont pas supprimées, elle seront utilisées par le cache, et peuvent être référencées.

containers/Multi_Stage_Builds.md

Builds multi-stage en pratique

Chaque étape est numérotée, en débutant à

0Nous pouvons copier un fichier d'une étape précédente en indiquant son numéro, par ex.:

COPY --from=0 /fichier/depuis/etape/une /chemin/dans/etape/couranteNous pouvons aussi nommer les étapes, et y faire référence:

FROM golang AS builderRUN ...FROM alpineCOPY --from=builder /go/bin/mylittlebinary /usr/local/bin/

containers/Multi_Stage_Builds.md

Builds multi-stage pour notre programme C

Nous allons changer notre Dockerfile pour:

donner un surnom à notre première étape:

compilerajouter une seconde étape utilisant la même image de base

ubuntuajouter le binaire

helloà la seconde étapevérifier que

CMDest dans la seconde étape

Le Dockerfile résultant est dans la prochaine diapo.

containers/Multi_Stage_Builds.md

Dockerfile du build multi-stage

Voici le Dockerfile final:

FROM ubuntu AS compilerRUN apt-get updateRUN apt-get install -y build-essentialCOPY hello.c /RUN make helloFROM ubuntuCOPY --from=compiler /hello /helloCMD /helloEssayons de le générer, et vérifions que cela fonctionne bien:

docker build -t hellomultistage .docker run hellomultistagecontainers/Multi_Stage_Builds.md

Comparaison des tailles d'image en build simple/multi-stage

Listez nos images avec docker images, et vérifiez la taille de:

l'image de base

ubuntu,l'image

helloà étape unique,l'image

hellomultistageà plusieurs étapes.

Nous pouvons arriver à des tailles d'images encore plus petites avec des images de base plus petites.

Toutefois, si nous utilisons une image de base commune (par ex. en prenant comme standard ubuntu), ces images en commun ne seront téléchargées qu'une fois par hôte, les rendant

virtuellement "gratuites".

containers/Multi_Stage_Builds.md

Cibles de build

On peut aussi étiqueter une étape intermédiaire avec

docker build --target STAGE --tag NAMECela va créer une image (appelée

NAME) correspondant à l'étapeSTAGEElle peut être utilisée pour accéder facilement à une étape intermédiaire pour inspection.

(Au lieu de fouiller l'affichage de

docker buildpour trouver l'ID d'image)Elle peut aussi être utilisée pour générer de multiples images avec un seul Dockerfile

(Au lieu d'utiliser plusieurs Dockerfiles, qu'il faudrait perpétuellement synchroniser)

containers/Multi_Stage_Builds.md

Publier des images sur le Docker Hub

(automatically generated title slide)

Publier des images sur le Docker Hub

Nous avons généré nos premières images.

Nous pouvons maintenant les publier vers le Docker Hub!

Vous n'avez pas à faire les exercices de cette section, parce qu'ils exigent un compte sur le Docker Hub, et nous ne voulons forcer personne à en créer un.

Veuillez noter, toutefois, que la création d'un compte sur le Docker Hub est gratuite (sans carte bancaire), et que l'hébergement d'images publiques est aussi gratuit.

containers/Publishing_To_Docker_Hub.md

Connexion au Docker Hub

- C'est faisable depuis la ligne de commande Docker:docker login

Depuis Docker sur Mac/Windows, ou Docker sur un

poste de travail Linux, on peut (et on préfére si possible)

s'intégrer avec le trousseau de clés du système pour stocker

les accès en sécurité. Toutefois, sur la plupart des serveurs

Linux, ce sera stocké par défaut dans ~/.docker/config.

containers/Publishing_To_Docker_Hub.md

Tags d'image et adresses de registre

Docker et ses tags d'images sont comme Git et ses tags/branches.

Ce sont des pointeurs vers un ID d'image spécifique.

Marquer une image ne renomme pas cette image: elle ne fait qu'ajouter une étiquette.

En poussant une image vers un registre distant, l'adresse de registre est dans le tag.

Example:

registry.example.net:5000/imageQu'en est-il des images du Docker Hub?

Tags d'image et adresses de registre

Docker et ses tags d'images sont comme Git et ses tags/branches.

Ce sont des pointeurs vers un ID d'image spécifique.

Marquer une image ne renomme pas cette image: elle ne fait qu'ajouter une étiquette.

En poussant une image vers un registre distant, l'adresse de registre est dans le tag.

Example:

registry.example.net:5000/imageQu'en est-il des images du Docker Hub?

jpetazzo/clockest, en fait,index.docker.io/jpetazzo/clockubuntuest, en fait,library/ubuntu, i.e.index.docker.io/library/ubuntu

containers/Publishing_To_Docker_Hub.md

Etiqueter une image pour la pousser sur le Hub

Ajoutons une étiquette à notre image

figlet(ou une autre):docker tag figlet jpetazzo/figletEt poussons-là sur le Hub:

docker push jpetazzo/figletC'est tout!

Etiqueter une image pour la pousser sur le Hub

Ajoutons une étiquette à notre image

figlet(ou une autre):docker tag figlet jpetazzo/figletEt poussons-là sur le Hub:

docker push jpetazzo/figletC'est tout!

N'importe qui peut maintenant

docker run jpetazzo/figletde partout.

containers/Publishing_To_Docker_Hub.md

Les vertus des builds automatisés

Vous pouvez lier un dépôt du Docker Hub avec un dépôt Github ou BitBucket.

Chaque push dans Github/Bitbucket va déclencher un build sur Docker Hub.

Si l'image est générée avec succès, elle sera disponible sur Docker Hub.

Vous pouvez associer tags et branches entre le code source et images de conteneurs.

Si vous maintenez des dépôts publics, tout ça est gratuit.

containers/Publishing_To_Docker_Hub.md

Installer un build automatisé

- Vous avez besoin d'un code source "Dockerisé"!

- Direction https://github.com/jpetazzo/trainingwheels pour le fork.

- Allez sur Docker Hub (https://hub.docker.com/) et connectez-vous. Sélectionnez "Repositories" dans la barre de navigation bleue.

- Connectez votre compte Docker Hub à votre compte Github.

- Cliquez sur le bouton "Create".

- Puis allez dans l'onglet "Builds".

- Cliquez sur l'icône Github et choisissez le compte/dépôt que nous avons juste fork.

- Dans le bloc "Builds rules" en bas de page, indiquez

/wwwdans la colonne "Build context" (ou le dossier qui contient le Dockerfile). - Cliquez "Save and build" pour lancer un build immédiatement (sans attendre le prochain git push).

- Les prochains builds seront automatiques, grâce aux notifications Github.

containers/Publishing_To_Docker_Hub.md

Astuces pour Dockerfiles efficaces

(automatically generated title slide)

Astuces pour Dockerfiles efficaces

Nous allons voir comment:

réduire le nombre de layers.

Exploiter le cache de build pour accélérer la construction.

Injecter les tests unitaires dans le processus de génération.

Réduire le nombre de layers

Chaque ligne du Dockerfile ajoute une nouvelle couche.

Ecrivez votre Dockerfile pour exploiter le système de cache de Docker.

Combinez les commandes avec

&&pour chainer les commandes et\pour empiler les lignes.

Note: il est fréquent d'écrire un Dockerfile ligne par ligne:

RUN apt-get install thisthingRUN apt-get install andthatthing andthatotheroneRUN apt-get install somemorestuffPuis le corriger très facilement avant déploiement:

RUN apt-get install thisthing andthatthing andthatotherone somemorestuffEviter de ré-installer les dépendances à chaque build

Problème classique de Dockerfile:

"chaque fois que je change une ligne de code, toutes mes dépendances sont ré-installées!"

Solution:

COPY-er les listes de dépendances (packages.json,requirements.txt, etc.) à part pour éviter de ré-installer des dépendances inchangées chaque fois.

Exemple de "mauvais" Dockerfile

Les dépendances sont ré-installées chaque fois, car le système de build ne sait pas si requirements.txt a été mis à jour.

FROM pythonWORKDIR /srcCOPY . .RUN pip install -qr requirements.txtEXPOSE 5000CMD ["python", "app.py"]Correction du Dockerfile

Ajouter les dépendances dans une étape à part permet à Docker un cache plus efficace, car il ne les installera que si requirements.txt change.

FROM pythonCOPY requirements.txt /tmp/requirements.txtRUN pip install -qr /tmp/requirements.txtWORKDIR /srcCOPY . .EXPOSE 5000CMD ["python", "app.py"]Injecter les tests unitaires dans le processus de génération.

FROM <baseimage>RUN <install dependencies>COPY <code>RUN <build code>RUN <install test dependencies>COPY <test data sets and fixtures>RUN <unit tests>FROM <baseimage>RUN <install dependencies>COPY <code>RUN <build code>CMD, EXPOSE ...- Le build échoue dès qu'une instruction échoue

- Si

RUN <unit tests>échoue, le build ne produira aucune image - S'il réussit, le build générera une image propre (sans librairie de test ni données)

Exemples de Dockerfile

(automatically generated title slide)

Exemples de Dockerfile

Il y a quelques astuces, conseils et techniques qu'on peut appliquer dans nos Dockerfiles.

Mais parfois, on se doit de passer par des formes différentes, voire opposées, selon:

la complexité du projet,

le langage de programmation ou le framework choisi,

l'étape du projet (nouveau MVP vs prod super-stable),

si nous générons une image finale, ou une base pour d'autres images,

etc.

Nous allons montrer quelques exemples de techniques très différentes.

Quand optimiser une image

Au moment d'écrire des images officielles, c'est une bonne idée de réduire au maximum:

le nombre de couches,

la taille finale de l'image.

C'est souvent au détriment du temps de génération et du confort pour le mainteneur de l'image; mais quand une image est téléchargée des millions de fois, économiser ne serait-ce qu'une poignée de secondes de délai vaut le coup.

RUN apt-get update && apt-get install -y libpng12-dev libjpeg-dev && rm -rf /var/lib/apt/lists/* \ && docker-php-ext-configure gd --with-png-dir=/usr --with-jpeg-dir=/usr \ && docker-php-ext-install gd...RUN curl -o wordpress.tar.gz -SL https://wordpress.org/wordpress-${WORDPRESS_UPSTREAM_VERSION}.tar.gz \ && echo "$WORDPRESS_SHA1 *wordpress.tar.gz" | sha1sum -c - \ && tar -xzf wordpress.tar.gz -C /usr/src/ \ && rm wordpress.tar.gz \ && chown -R www-data:www-data /usr/src/wordpress(Source: Image officielle Wordpress)

Quand ne pas optimiser une image

Parfois, il est préférable de prioriser le confort du mainteneur

En particulier, si:

l'image change beaucoup,

l'image a peu d'utilisateurs (par ex. 1 seul, le mainteneur!),

l'image est générée et lancée sur la même machine,

l'image est générée et lancée sur des machines sur un réseau très rapide...

Dans ces cas, mieux vaut garder les choses simples!

(Prochaine diapo: un Dockerfile qui peut être utilisé pour un aperçu de site Jekyll / github pages)

FROM debian:sidRUN apt-get update -qRUN apt-get install -yq build-essential makeRUN apt-get install -yq zlib1g-devRUN apt-get install -yq ruby ruby-devRUN apt-get install -yq python-pygmentsRUN apt-get install -yq nodejsRUN apt-get install -yq cmakeRUN gem install --no-rdoc --no-ri github-pagesCOPY . /blogWORKDIR /blogVOLUME /blog/_siteEXPOSE 4000CMD ["jekyll", "serve", "--host", "0.0.0.0", "--incremental"]Système de version multi-dimensionnels

Un tag d'image peut indiquer une version de l'image.

Mais parfois, plusieurs composants importants co-existent, et nous devons indiquer les versions de chacun.

C'est possible en passant par des variables d'environnement:

ENV PIP=9.0.3 \ ZC_BUILDOUT=2.11.2 \ SETUPTOOLS=38.7.0 \ PLONE_MAJOR=5.1 \ PLONE_VERSION=5.1.0 \ PLONE_MD5=76dc6cfc1c749d763c32fff3a9870d8d(Source: Image officielle Plone)

Entrypoints et démarreurs

Il est très courant de définir un entrypoint spécifique.

Ce point d'entrée est généralement un script, réalisant une série d'opérations telles que:

vérifications avant démarrage (si une dépendance obligatoire n'est pas disponible, afficher un message d'erreur sympa au lieu d'un obscur paquet de lignes dans un fichier log);

génération ou validation de fichier de configuration;

limiter les privilèges (avec par ex.

suougosu, parfois combiné avecchown);et plus encore.

Un script d'entrypoint typique

#!/bin/sh set -e # first arg is '-f' or '--some-option' # or first arg is 'something.conf' if [ "${1#-}" != "$1" ] || [ "${1%.conf}" != "$1" ]; then set -- redis-server "$@" fi # allow the container to be started with '--user' if [ "$1" = 'redis-server' -a "$(id -u)" = '0' ]; then chown -R redis . exec su-exec redis "$0" "$@" fi exec "$@"(Source: Image officielle Redis)

Factoriser les informations

Pour faciliter la maintenance (et éviter les erreurs humaines), évitez de répéter des informations comme:

numéros de versions,

URLs de ressources distantes (par ex. fichiers tarballs) ...

Pour ce faire, utilisez des variables d'environnement.

ENV NODE_VERSION 10.2.1...RUN ... && curl -fsSLO --compressed "https://nodejs.org/dist/v$NODE_VERSION/node-v$NODE_VERSION.tar.xz" \ && curl -fsSLO --compressed "https://nodejs.org/dist/v$NODE_VERSION/SHASUMS256.txt.asc" \ && gpg --batch --decrypt --output SHASUMS256.txt SHASUMS256.txt.asc \ && grep " node-v$NODE_VERSION.tar.xz\$" SHASUMS256.txt | sha256sum -c - \ && tar -xf "node-v$NODE_VERSION.tar.xz" \ && cd "node-v$NODE_VERSION" \...(Source: Image officielle Nodejs)

Surcharge

En théorie, les images de production et développement devraient être les mêmes.

En pratique, nous avons souvent besoin d'activer des comportements spécifiques en développement (par ex. trace de debogage).

Une façon de concilier les deux besoins est d'utiliser Compose pour activer ces comportements.

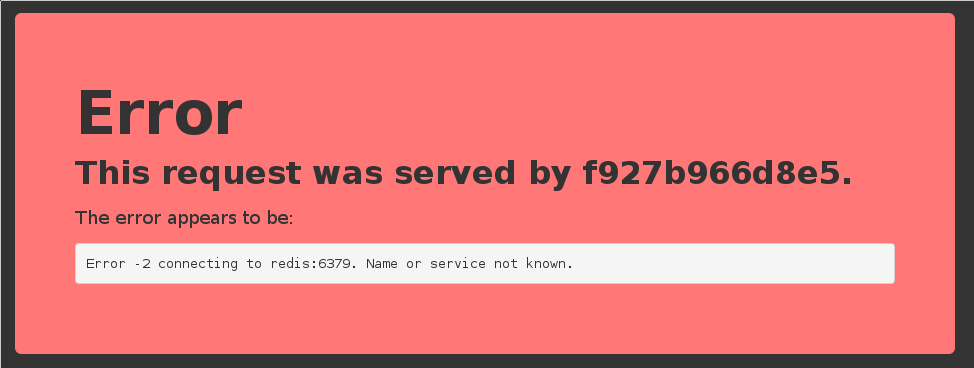

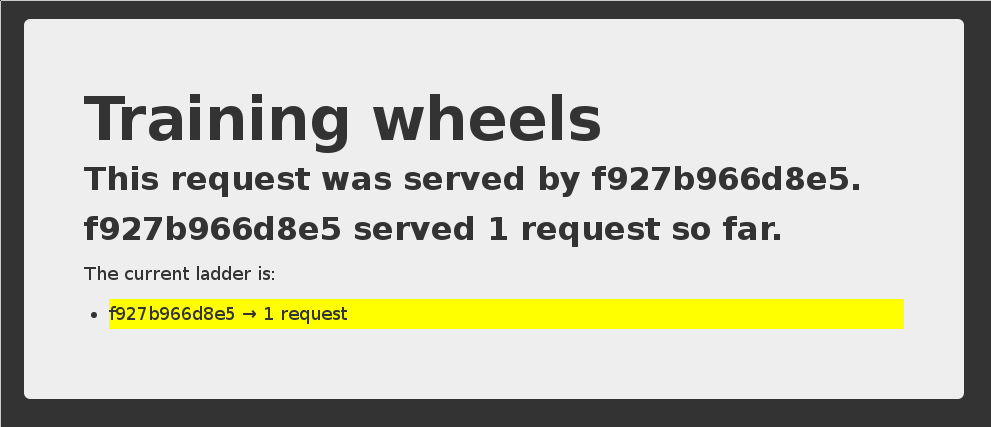

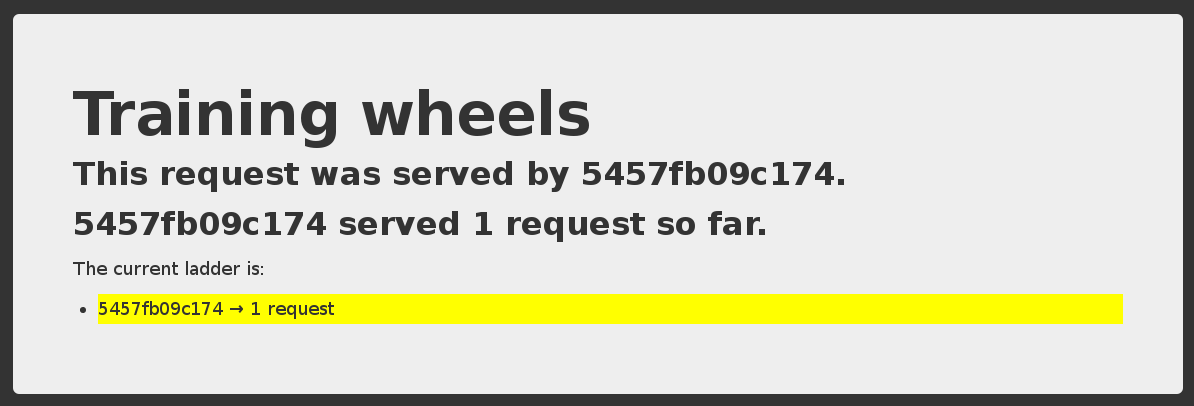

Jetons un oeil à l'appli de démo trainingwheels comme exemple.

Image de production

Le Dockerfile génère une image exploitant gunicorn:

FROM pythonRUN pip install flaskRUN pip install gunicornRUN pip install redisCOPY . /srcWORKDIR /srcCMD gunicorn --bind 0.0.0.0:5000 --workers 10 counter:appEXPOSE 5000(Source: Dockerfile trainingwheels)

Fichier Compose de développement

Ce fichier Compose utilise la même image, mais avec quelques valeurs surchargées en développement:

On préfère le serveur Flask de développement (surcharge de

CMD);On définit la variable d'environnement

DEBUG;On utilise un volume pour fournir un processus de développement local plus rapide.

services: www: build: www ports: - 8000:5000 user: nobody environment: DEBUG: 1 command: python counter.py volumes: - ./www:/src(Source: Fichier Compose trainingwheels)

Comment choisir quelles bonnes pratiques sont les meilleures?

Le but principal des conteneurs est de rendre notre vie meilleure;

Dans ce chapitre, nous avons montré bien des façons d'écrire des Dockerfiles;

Ces Dockerfiles utilisent parfois des techniques diamétralement opposées;

Et pourtant, c'était la "bonne" technique pour cette situation spécifique;

C'est bien (et souvent encouragé) de commencer simple et d'évoluer selon le besoin;

N'hésitez pas à revoir ce chapitre plus tard (après quelques Dockerfiles) pour inspiration!

Dockerfiles avancés

(automatically generated title slide)

Objectifs

Nous avons vu des Dockerfiles simples pour illustrer comment Docker construit des images de conteneurs.

Dans cette section, nous allons voir d'autres commandes propres aux Dockerfiles.

containers/Advanced_Dockerfiles.md

Dockerfile, l'essentiel

Les instructions d'un

Dockerfilesont exécutées dans l'ordre.Chaque instruction ajoute une nouvelle couche à l'image (layer).

Docker gère un cache avec les layers des builds précédents.

Quand rien ne change dans les instructions ou les fichiers qui définissent un layer, le builder récupère la version en cache, sans exécuter l'instruction de ce layer.

L'instruction

FROMDOIT être la première instruction (hormis les commentaires).Les lignes débutant par

#sont considérées comme des commentaires.Quelques instructions (comme

CMDetENTRYPOINT) concernent les méta-données. (avec pour conséquence que chaque mention de ces instructions rend les précédentes obsolètes)

containers/Advanced_Dockerfiles.md

Instruction RUN

L'instruction RUN peut être utilisée de deux manières.

Via le shell wrapping, qui exécute la commande spécifiée dans un shell,

avec /bin/sh -c, exemple:

RUN apt-get updateOu via la méthode exec, qui évite l'expansion de chaine du shell, et

permet l'exécution pour les images qui n'embarquent pas /bin/sh, i.e. :

RUN [ "apt-get", "update" ]containers/Advanced_Dockerfiles.md

RUN plus en détail

RUN est utile pour:

- Exécuter une commande.

- Enregistrer les changements du système de fichiers.

- Installer efficacement des bibliothèques, paquets et divers fichiers.

RUN n'est pas fait pour:

- Enregistrer l'état des processus

- Démarrer automatiquement un process en tache de fond (daemon).

Si vous voulez démarrer automatiquement un processus quand le container se lance,

vous devriez passer par CMD et/ou ENTRYPOINT.

containers/Advanced_Dockerfiles.md

Fusion de layers:

Il est possible d'exécuter plusieurs commandes d'un seul coup:

RUN apt-get update && apt-get install -y wget && apt-get cleanIl est aussi possible de répartir une même commande sur plusieurs lignes:

RUN apt-get update \ && apt-get install -y wget \ && apt-get cleancontainers/Advanced_Dockerfiles.md

Instruction EXPOSE

L'instruction EXPOSE indique à Docker quels ports doivent être publiés

pour cette image.

EXPOSE 8080EXPOSE 80 443EXPOSE 53/tcp 53/udpTous les ports sont privés par défaut;

Déclarer un port avec

EXPOSEne suffit pas à le rendre public;Le

Dockerfilene contrôle pas sur quel port un service sera exposé.

containers/Advanced_Dockerfiles.md

Exposer des ports

Quand vous lancez

docker run -p <port> ..., ce port devient public;(Même s'il n'a pas été déclaré via

EXPOSE.)Quand vous lancez

docker run -P...(sans numéro de port), tous les ports déclarés viaEXPOSEdeviennent publics.

Un port public est accessible depuis les autres containers et depuis l'extérieur de la machine hôte.

Un port privé n'est pas accessible depuis l'extérieur.

containers/Advanced_Dockerfiles.md

Instruction COPY

L'instruction COPY ajoute des fichiers et du contenu depuis votre machine hôte

vers l'image.

COPY . /srcCela va ajouter le contenu du build context (le dossier passé en argument

à la commande docker build) au dossier /src dans l'image.

containers/Advanced_Dockerfiles.md

Isolation du build context

Note: vous pouvez manipuler uniquement les fichiers et dossier contenus dans le build context. Tout chemin absolu est traité comme ayant pour racine le build context, i.e que les 2 lignes suivantes sont équivalentes:

COPY . /srcCOPY / /srcToute tentative d'utiliser .. pour sortir du build context sera

détectée et bloquée par Docker, et le build échouera.

Sans cela, un Dockerfile pourrait être valide sur une machine A, mais échouer sur une machine B.

containers/Advanced_Dockerfiles.md

Instruction ADD

ADD fonctionne presque comme COPY, mais avec quelques petits plus.

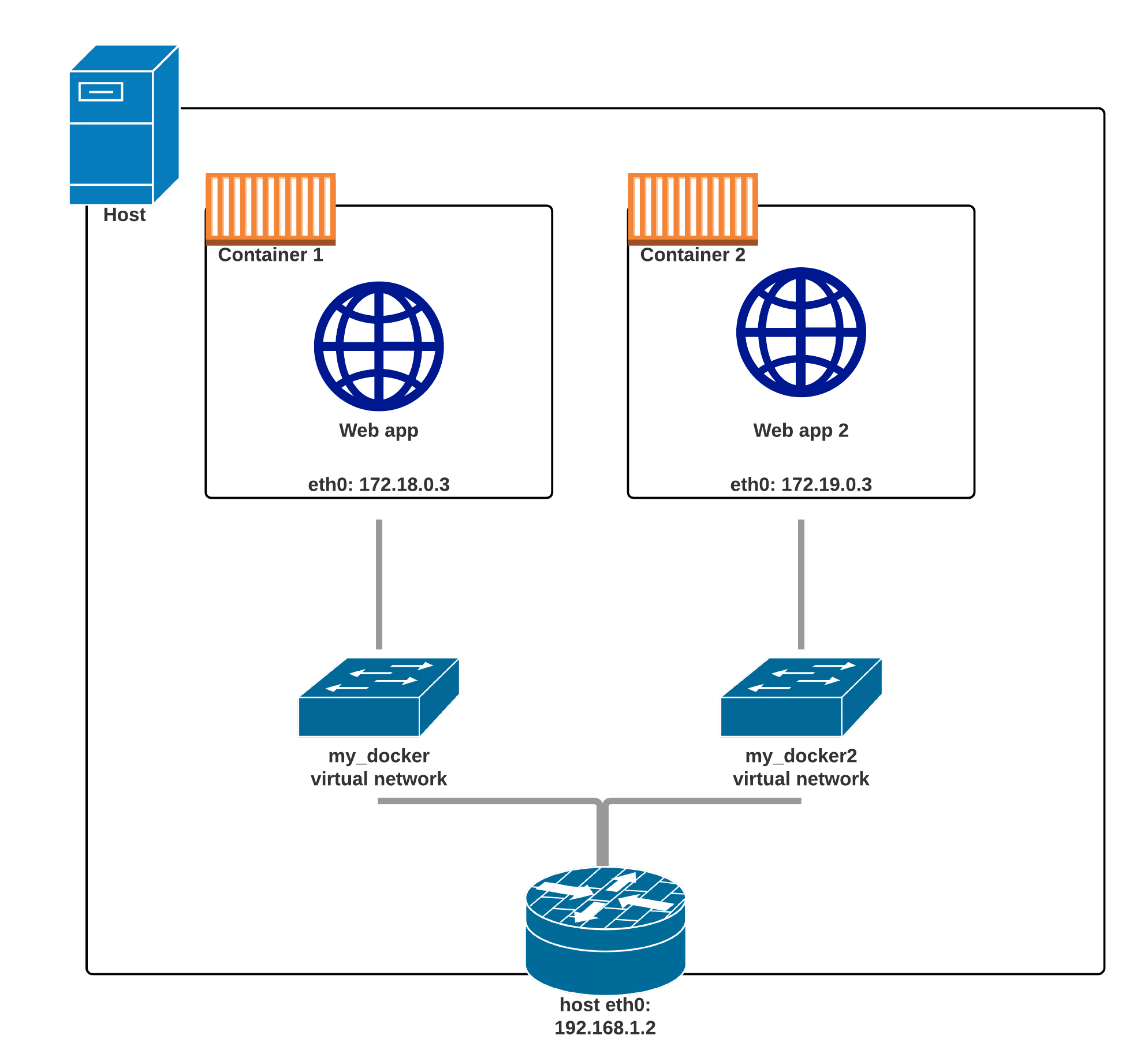

ADD peut récupérer des fichiers à distance: